IA e vigilância por vídeo: transformando a busca em vídeos

A busca semântica de vídeo impulsionada por IA traz significado aos feeds de CFTV. Ela vai além de etiquetas e comparação de pixels para interpretar cenas, ações e intenções. Na prática, um operador de segurança pode digitar uma frase natural e recuperar os vídeos mais relevantes, não apenas frames que correspondam a uma cor ou forma. Por exemplo, em vez de localizar um “carro vermelho”, os operadores podem buscar por “pessoa entrando em uma área restrita” e encontrar os segmentos de vídeo exatos. Essa mudança transforma a forma de trabalho das equipes, pois reduz o tempo gasto percorrendo linhas do tempo e aumenta a consciência situacional.

Forças de mercado impulsionam essa mudança. O mercado global de vigilância por vídeo está projetado para atingir USD 144,4 bilhões até 2027 com um CAGR de 10,4% (fonte). Ao mesmo tempo, os sistemas de CFTV produzem enormes quantidades de dados de vídeo todos os dias. Estimativas apontam para mais de um bilhão de câmeras de vigilância operacionais no mundo, com petabytes de imagens geradas diariamente (fonte). Consequentemente, a revisão manual não escala. Sistemas semânticos escalam melhor, porque indexam significado e não apenas características de baixo nível.

A busca semântica de vídeo usando IA funde visão computacional, linguagem natural e metadados contextuais. Ela permite que usuários formulem consultas complexas em linguagem natural e recebam resultados ranqueados. Grandes modelos de linguagem e modelos de visão interpretam a intenção do usuário e mapeiam-na para descritores de vídeo. Como resultado, a tecnologia de busca torna-se conversacional. visionplatform.ai aplica essas ideias para transformar câmeras existentes e VMS em sensores operacionais pesquisáveis. Casos de uso forense, como reconstrução rápida de incidentes, se beneficiam diretamente. Para um exemplo forense aprofundado, veja nosso recurso de busca forense em aeroportos, que mostra como descrições em linguagem natural aceleram investigações.

Primeiro, sistemas semânticos marcam objetos e ações. Em seguida, armazenam índices semânticos para recuperação rápida. Depois, os operadores consultam usando linguagem simples e obtêm clipes contextuais. Finalmente, as equipes verificam e agem. Esse fluxo de trabalho reduz falsos positivos e resulta em respostas mais rápidas. Para equipes que monitoram perímetros, veja os exemplos práticos de detecção em nossa página de detecção de intrusões em aeroportos para entender como alertas contextuais reduzem ruído. No geral, IA e busca semântica elevam o CFTV de um gravador passivo para uma fonte de conhecimento ativa e pesquisável.

computer vision and metadata: extract meaningful insights

Modelos de visão computacional formam a espinha dorsal do processamento semântico. Convolutional Neural Networks (CNNs) detectam objetos em frames de vídeo. Redes recorrentes e modelos temporais vinculam detecções entre frames para reconhecer ações e interações. Em resumo, esses modelos traduzem pixels em eventos. Em seguida, camadas de metadados adicionam contexto legível por humanos. Metadados anotam quem fez o quê, quando e onde. Essa anotação transforma imagens brutas em conteúdo pesquisável.

Modelos profundos rotulam pessoas, veículos e comportamentos. Eles também atribuem atributos como cor da roupa, direção e tipo de atividade. Esses metadados podem incluir descrições em linguagem natural para cada segmento de vídeo. visionplatform.ai usa um Vision Language Model on-prem para converter detecções em descrições textuais e fornecer metadados prontos para busca. Como resultado, operadores podem pesquisar usando frases simples como “pessoa em permanência suspeita perto do portão fora do horário”. Para um caso de uso relacionado, confira nossa orientação sobre detecção de permanência suspeita em aeroportos.

Estudos mostram grandes ganhos operacionais. A busca semântica pode reduzir o tempo de revisão manual em até 70% (fonte). Em muitas implantações, redes profundas atingem taxas de acurácia acima de 90% para reconhecimento de atividades complexas (fonte). Esses números importam porque diminuem o ônus sobre examinadores humanos e melhoram a qualidade das evidências. Além disso, metadados possibilitam indexação e busca eficiente em vastas bibliotecas de vídeo, de modo que equipes encontrem clipes rapidamente sem uma varredura manual exaustiva.

Na prática, os sistemas devem equilibrar acurácia e latência. Marcação de baixa latência permite que operadores ajam em tempo real enquanto a anotação completa suporta trabalho forense posterior. A anotação semântica possibilita sumarização de vídeo, indexação temporal e trilhas de auditoria. Além disso, visão computacional e aprendizado de máquina combinados criam um pipeline que extrai eventos, etiqueta contexto e armazena metadados para recuperação rápida. Esse pipeline permite melhor consciência situacional e melhora a tomada de decisão operacional em salas de controle movimentadas.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

vector, embeddings and vector database: powering vector search

Embeddings mapeiam conceitos visuais em números. Um embed é uma representação numérica compacta. Embeddings gerados a partir de frames ou segmentos capturam semântica em um formato adequado para operações de similaridade. Em um espaço vetorial, cenas similares ficam próximas umas das outras. Portanto, consultas tornam-se buscas por vetores em vez de correspondência por palavras-chave. Essa abordagem possibilita recuperação escalável e flexível em conjuntos de dados de vídeo.

Para ser preciso, um vetor de alta dimensão captura aparência, ação e pistas contextuais. O sistema armazena esses vetores em um banco de dados vetorial para busca por similaridade rápida. Um banco de dados vetorial suporta busca por vizinhos mais próximos e indexação otimizada. Ele também possibilita respostas de baixa latência para uso em tempo real. Por exemplo, quando um operador envia uma consulta, o sistema codifica a consulta como um vetor e recupera os vetores mais próximos que representam segmentos de vídeo relevantes. Essa busca vetorial suporta recuperação de segmentos de vídeo temporalmente ligados e clipes inteiros que correspondem à intenção semântica.

Fluxos de trabalho para busca vetorial seguem passos claros. Primeiro, ingerir arquivos de vídeo e dividi-los em segmentos. Em seguida, executar modelos pré-treinados ou específicos da tarefa para produzir embeddings. Depois, persistir embeddings em um banco de dados vetorial e vinculá-los a metadados e timestamps. Finalmente, aceitar consultas que são codificadas em vetores e retornar resultados ranqueados. Esse processo produz busca por similaridade precisa e recuperação rápida de conteúdo de vídeo relevante. Também suporta busca por similaridade entre diferentes tipos de vídeo e câmeras.

Métodos vetoriais escalam com os dados. Eles têm bom desempenho em grandes conjuntos de dados de vídeo e permitem indexação e busca eficientes. Sistemas podem combinar correspondência vetorial com filtros baseados em regras para políticas e conformidade. Além disso, a busca vetorial integra-se a VMS e fluxos de trabalho existentes. visionplatform.ai mapeia descrições em linguagem de visão para vetores para que operadores possam usar consultas em linguagem natural e receber resultados precisos. Além disso, equipes podem executar o banco de dados vetorial on-prem para atender regras de proteção de dados e reduzir dependência da nuvem. No geral, vetores e embeddings são o motor que torna possível a busca semântica eficiente em vídeo.

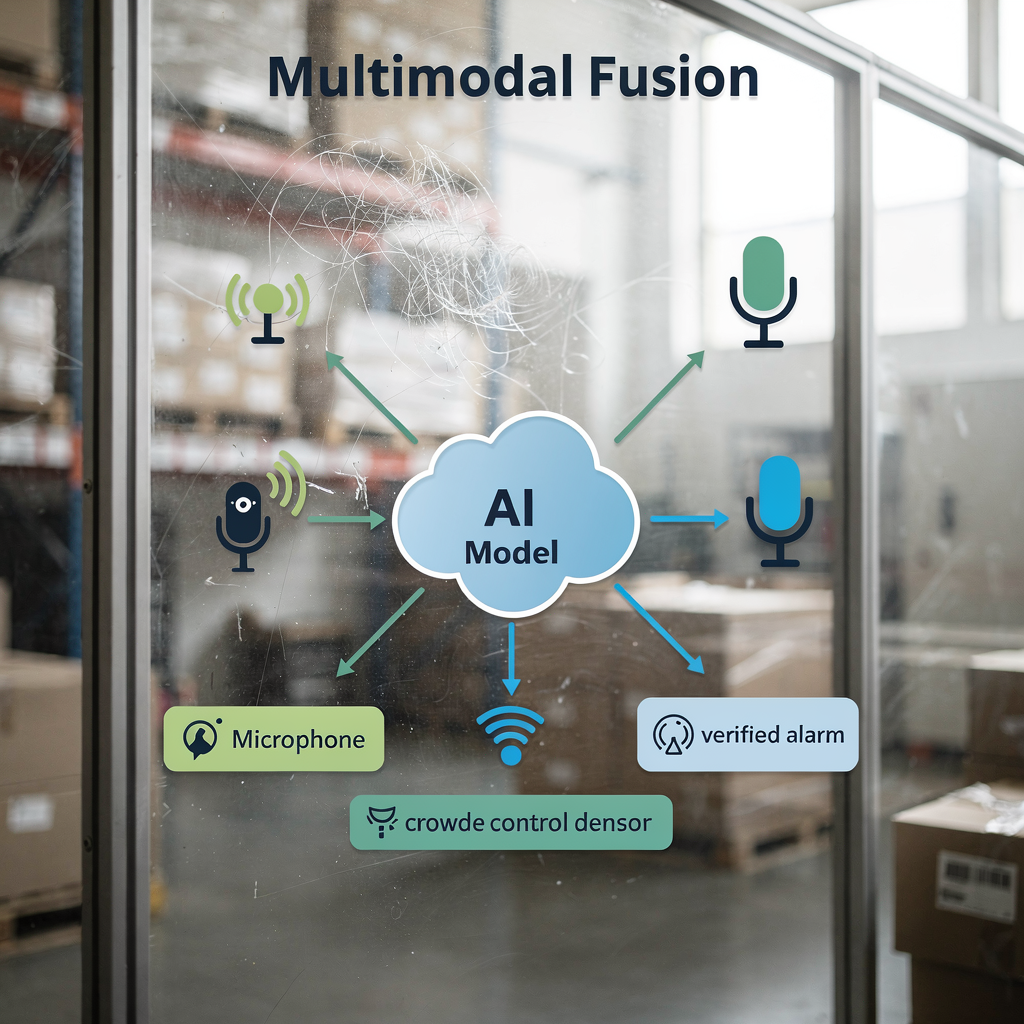

machine learning and multimodal: enriching context

Fusão multimodal melhora a acurácia ao combinar sinais. Vídeo, áudio e feeds de sensores fornecem pistas únicas. Por exemplo, combinar pistas visuais com níveis de som melhora a detecção de comportamentos em multidões. Quando modelos observam padrões de movimento e aumento do som, detectam agitação com mais confiabilidade. Assim, abordagens multimodais reduzem alarmes falsos e aumentam a confiança nos alertas.

Modelos de aprendizado de máquina aprendem a ponderar entradas. Eles integram embeddings visuais com registros textuais, eventos de controle de acesso ou sensores IoT. Essa integração ajuda a confirmar incidentes e fornecer contexto mais rico. Por exemplo, uma entrada de controle de acesso combinada com uma detecção facial correspondente fornece evidência mais robusta do que cada fonte isolada. O VP Agent Reasoning da visionplatform.ai correlaciona análises de vídeo com dados do VMS e procedimentos para explicar por que um alarme é relevante. A plataforma então recomenda ações ou pré-preenche relatórios de incidente para acelerar a resposta.

Grandes modelos multimodais também possibilitam descoberta de conteúdo mais rica. Eles aceitam vídeo mais relatórios textuais ou metadados e aprendem embeddings conjuntos. Como resultado, consultas expressas em linguagem natural produzem recuperações mais precisas. Em sistemas que monitoram aeroportos, a detecção multimodal auxilia na análise de fluxo de pessoas e densidade de multidões; veja nosso recurso de detecção de densidade de multidões em aeroportos. A fusão de dados suporta sumarização de vídeo e geração automática de relatórios, o que melhora a produtividade dos operadores e a clareza situacional.

Finalmente, pipelines multimodais aumentam desempenho sem sacrificar conformidade. Implantações on-prem ou na borda permitem que organizações mantenham vídeo bruto e dados de sensores localmente. Esse design protege a privacidade e alinha-se com regras regionais. A combinação de aprendizado de máquina e entradas multimodais impulsiona análises mais ricas, melhor verificação e, em última instância, segurança aprimorada para operações em escala.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

artificial intelligence and large language models: refining user queries

Grandes modelos de linguagem traduzem intenção humana em consultas acionáveis. Operadores escrevem descrições em linguagem natural e o modelo as mapeia para índices semânticos. Na prática, um usuário pode perguntar, “comportamento suspeito perto de um caixa eletrônico à noite.” O sistema codifica essa frase, encontra embeddings correspondentes e retorna clipes de vídeo ranqueados. Esse processo oculta a complexidade do operador e agiliza investigações.

Pipelines de PLN convertem texto longo do usuário em vetores semânticos concisos. Depois, o sistema combina esses vetores com filtros de metadados como intervalo de tempo ou ID da câmera. Essa abordagem híbrida melhora tanto precisão quanto recall. Além disso, o fine-tuning de modelos de IA para cenários específicos de CFTV aumenta a relevância. Por exemplo, um modelo treinado em conjuntos de dados de aeroportos reconhecerá melhor congestionamento em portas de embarque e violações de acesso. Para buscas específicas de domínio, considere nosso guia de detecção de pessoas em aeroportos.

A busca por vídeo com IA adiciona capacidades conversacionais às salas de controle. Operadores podem iterar com consultas de acompanhamento e refinar resultados. Sistemas também podem explicar por que clipes correspondem a uma consulta ao exibir descrições em linguagem natural e realces visuais. Essa transparência ajuda operadores a confiar na saída e agir mais rápido. Ademais, indexação e busca tornam-se mais resilientes à medida que modelos pré-treinados se adaptam com exemplos específicos da tarefa. Equipes podem usar pretreinamento contrastivo linguagem-imagem e depois ajustar em conjuntos de vídeo locais para aumentar acurácia e velocidade.

Por fim, uma abordagem integrada suporta respostas de baixa latência e auditabilidade. Ao implantar modelos on-prem, organizações mantêm dados privados enquanto possibilitam buscas rápidas e seguras. visionplatform.ai usa um Vision Language Model on-prem e agentes de IA para ligar busca a raciocínio e ações. Essa combinação permite que operadores recuperem conteúdo de vídeo relevante rapidamente e executem fluxos verificados com passos manuais mínimos. O resultado é uma experiência de busca mais precisa, explicável e útil para equipes de vigilância por vídeo.

future of video: trends, ethics and safeguards

O futuro do vídeo enfatiza alertas semânticos em tempo real e processamento na borda. À medida que o processamento se desloca para a borda, sistemas fornecem inferência de baixa latência e proteção local de dados. Implantações de edge reduzem largura de banda e protegem dados de vídeo sensíveis. Ao mesmo tempo, arquiteturas suportarão modelos híbridos que executam inferência leve em dispositivos e modelos mais pesados em servidores locais.

Questões éticas e de privacidade exigem salvaguardas robustas. Ferramentas de vigilância podem ser mal utilizadas, e os riscos incluem direcionamento discriminatório e vinculação não autorizada de dados. Pesquisadores destacam desafios de segurança e privacidade em sistemas modernos de vigilância e recomendam proteções como minimização de dados, controles de acesso e logs auditáveis (fonte). Regulamentações como a EU AI Act também pressionam por implantações transparentes e controláveis. Portanto, as equipes devem adotar governança que combine controles técnicos com políticas e supervisão.

Olhando adiante, a pesquisa se concentrará em escalonamento responsável. Modelos devem lidar com grandes volumes de dados preservando direitos individuais. Técnicas como federated learning e metadados anonimizados podem ajudar. Além disso, as melhores práticas da indústria incluirão explicabilidade, testes de viés e curadoria cuidadosa de conjuntos de dados. Para recursos práticos de detecção que podem ser implementados de forma responsável, reveja nossos exemplos de detecção de violação de perímetro em aeroportos e detecção de acesso não autorizado em aeroportos.

Finalmente, a inovação trará fluxos de trabalho mais automatizados. A autonomia expandirá com cautela, com controles humano-no-loop e trilhas de auditoria. Sistemas como o VP Agent Auto planejam possibilitar respostas autônomas para cenários de baixo risco enquanto preservam supervisão. No geral, o futuro do vídeo equilibra capacidades mais ricas com proteções mais fortes para entregar soluções de vigilância eficientes, confiáveis e responsáveis.

FAQ

What is semantic video search in CCTV?

A busca semântica de vídeo interpreta o conteúdo de vídeo para retornar resultados com base no significado em vez de pixels brutos. Ela usa modelos de IA e metadados para encontrar eventos, comportamentos ou cenários descritos em linguagem natural.

How does vector search help find relevant video?

A busca vetorial converte conceitos visuais e textuais em vetores numéricos e os armazena em um banco de dados vetorial. Em seguida, a busca por similaridade recupera as correspondências mais próximas, permitindo a recuperação rápida de conteúdo de vídeo relevante.

Can semantic systems work in real-time?

Sim. Computação na borda e pipelines otimizados possibilitam análise de vídeo em tempo real e alertas de baixa latência. Sistemas podem executar inferência leve em câmeras e modelos mais robustos em servidores locais para resposta rápida.

Are there privacy risks with semantic search?

Sim. Capacidades semânticas podem aumentar o risco de uso indevido se não forem governadas adequadamente. Implementar controles de acesso, implantações on-prem e logs de auditoria reduz a exposição à privacidade.

What datasets do models need?

Modelos se beneficiam de conjuntos de dados de vídeo diversos e anotados que reflitam o ambiente de implantação. Fine-tuning em conjuntos de vídeo locais específicos da tarefa melhora a acurácia e reduz falsos positivos.

How do large language models improve queries?

Grandes modelos de linguagem traduzem descrições em linguagem natural em vetores semânticos que se alinham com embeddings de vídeo. Esse mapeamento torna as buscas conversacionais e mais precisas.

Can multimodal fusion improve detection?

Sim. Combinar vídeo com áudio, sensores ou registros textuais fornece contexto mais rico e maior confiança nos alertas. Modelos multimodais reduzem ambiguidade e melhoram a verificação.

What is a vector database and why use it?

Um banco de dados vetorial armazena vetores de alta dimensão e suporta busca por vizinhos mais próximos para similaridade. Ele possibilita recuperação rápida e escala eficientemente para grandes conjuntos de dados de vídeo.

How does metadata help investigations?

Metadados anotam quem, o quê, quando e onde em segmentos de vídeo, o que acelera a revisão forense. Eles suportam indexação e permitem que operadores pesquisem entre câmeras e linhas do tempo de forma eficaz.

Is autonomous operation possible for CCTV systems?

Operação autônoma é possível para tarefas de baixo risco e repetíveis com supervisão humana e trilhas de auditoria. Sistemas podem automatizar fluxos de trabalho rotineiros enquanto mantêm procedimentos de escalonamento e revisão.