Fundamentos da IA em Vídeo

A IA está no centro das abordagens modernas para entendimento de vídeo. Nesse contexto, IA refere-se a sistemas que interpretam dados visuais, raciocinam sobre sequências e fornecem saídas acionáveis. Sistemas de IA frequentemente combinam visão computacional CLÁSSICA com aprendizado estatístico e componentes de linguagem natural. Machine learning e algoritmos de aprendizado de máquina impulsionam muitos desses sistemas. Eles treinam modelos que podem detectar objetos, classificar ações e resumir conteúdo ao longo de uma sequência de vídeo. A mudança da detecção a nível de frame para a compreensão semântica não é apenas técnica. Também altera como operadores e sistemas tomam decisões.

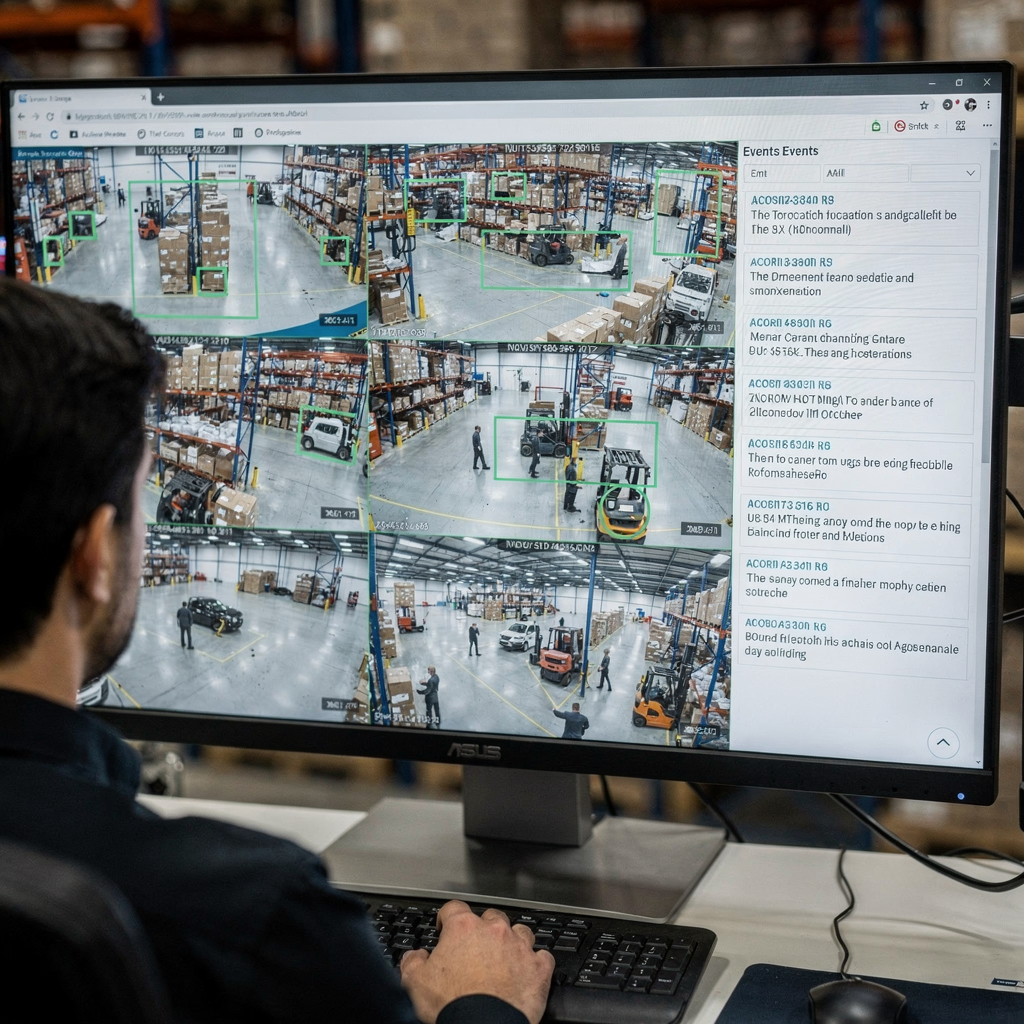

Pipelines iniciais focavam um frame por vez. Um único frame podia mostrar uma pessoa ou um veículo. Sistemas produziram uma caixa delimitadora e um rótulo. Essas saídas respondiam a tarefas simples de detecção. Hoje, a IA constrói sobre essas saídas por frame e aprende contexto ao longo de muitos frames. Ela raciocina sobre causalidade, intenção e comportamento ao longo do tempo. Essa compreensão de alto nível reduz falsos positivos e suporta suporte à decisão em salas de controle. Por exemplo, visionplatform.ai adiciona uma camada de raciocínio que converte detecções em situações explicadas e ações recomendadas. Essa abordagem ajuda operadores a passar de alertas brutos para incidentes verificados.

Métricas de desempenho chave guiam a avaliação. Precisão mede com que frequência as decisões coincidem com a verdade de referência. Throughput mede quantos frames por segundo um sistema pode processar. Latência mede o tempo desde a entrada até a decisão. Uso de recursos também importa. Implantações na borda podem precisar de modelos ajustados para menor memória e capacidade de computação. Portanto, benchmarks relatam precisão, frames processados por segundo e latência de ponta a ponta. Praticantes também acompanham o custo de alarmes falsos porque o volume importa em ambientes operacionais.

A definição das escolhas de projeto importa. Um único frame pode ser claro, porém ambíguo. Frames individuais frequentemente omitem pistas de movimento, enquanto uma sequência de vídeo dá contexto como direção, velocidade e interação. Sistemas robustos, portanto, fundem características de frames, áudio e metadados. Essa fusão impulsiona o entendimento de conteúdo e desbloqueia aplicações de vídeo em segurança, varejo e esportes. Para contexto acadêmico, veja métodos para análise qualitativa de vídeo que mostram por que o contexto importa na interpretação aqui.

Detecção e Reconhecimento de Objetos em Vídeos

A detecção forma a base de muitos pipelines. Detecção de objetos identifica e localiza objetos dentro de um frame usando uma caixa delimitadora ou mapa de segmentação. Modelos clássicos de detecção incluem Faster R-CNN e YOLO, e eles permanecem pontos de referência ao construir sistemas para operações em tempo real. Esses modelos rodam em frames, propõem regiões candidatas e atribuem pontuações de classe. Variantes otimizadas e poda ajudam a atingir metas de tempo real em dispositivos de borda.

Desafios específicos de vídeo complicam métodos padrão. Motion blur, movimento de câmera, mudanças de iluminação e oclusão causam instabilidade entre frames. O tracking ajuda ao associar o mesmo objeto ao longo do tempo, então rastreamento de objetos melhora persistência e identidade. Para algumas implantações, combinar detecção de objetos e rastreamento oferece trilhas estáveis e menos reidentificações. Um modelo de detecção deve portanto lidar tanto com precisão espacial quanto consistência temporal.

O desempenho no campo importa. Sistemas de CFTV com análises modernas reduzem incidentes na prática. Por exemplo, um estudo relatou uma diminuição de 51% nas taxas de criminalidade em estacionamentos com cobertura por câmeras, destacando benefícios tangíveis quando a detecção é pareada com respostas operacionais fonte. Essa estatística enfatiza por que detecção de objetos precisa e rastreamento estável são cruciais para segurança pública e proteção de ativos.

Praticantes também enfrentam restrições sobre anotação e qualidade de datasets. Anotar frames desenhando caixas delimitadoras continua sendo demorado, então ferramentas de anotação semi-automatizadas reduzem o esforço. visionplatform.ai suporta fluxos de trabalho que permitem equipes melhorar modelos pré-treinados com classes específicas do site e mantém os dados localmente para conformidade e privacidade. Essas escolhas afetam a generalização do modelo e o custo de implantação.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Detecção de Ações e Classificação de Vídeo

Detecção de ação estende a detecção ao tempo. Ela rotula quando uma ação ocorre e onde. Essa tarefa requer modelos que raciocinem sobre um segmento de vídeo, não sobre um único frame. Classificação de vídeo atribui um rótulo a todo um clipe ou a segmentos dentro dele. A diferença é importante: classificadores de frame único testam uma imagem estática, enquanto modelos de sequência aprendem dinâmicas temporais. Tarefas como reconhecimento de ação e detecção de ação dependem de modelos temporais como 3D CNNs ou arquiteturas baseadas em LSTM que processam uma sequência de vídeo.

3D CNNs extraem características espaço-temporais aplicando convoluções tanto no espaço quanto no tempo. Modelos de sequência baseados em LSTM ou transformers lidam com dependências de longo alcance e podem agregar características por frame em um resumo significativo. Esses modelos resolvem tarefas de detecção como “pessoa correndo” ou “interação suspeita” ao longo de frames de um vídeo. Para testes práticos, datasets de esportes e de vigilância fornecem rótulos de ação diversos e interações complexas para desafiar modelos.

Comparar abordagens esclarece trade-offs. Uma abordagem por frame pode detectar objetos e poses simples rapidamente, mas perde contexto como quem iniciou um contato ou se uma ação de vídeo está em curso. Modelos de sequência capturam dinâmicas, porém podem aumentar a latência e requerer mais dados de treinamento. Muitos sistemas combinam ambos: um detector rápido por frame fornece candidatos, e um modelo temporal refina a decisão ao longo de uma janela deslizante.

A avaliação usa métricas como mean Average Precision para localização, F1 para detecção de eventos e top-1 accuracy para classificação. Quando o objetivo é operacional, métricas adicionais como taxa de falsos alarmes, tempo para detectar e a habilidade de vincular detecções entre câmeras importam. Essas considerações moldam implantações no mundo real, desde treinamentos esportivos que precisam de feedback detalhado até vigilância de vídeo onde alertas oportunos reduzem o tempo de resposta. Validação humana e pesquisa sobre detecção de discursos políticos manipulados ressaltam a dificuldade da verificação e a necessidade de ferramentas que apoiem operadores com explicações contextuais estudo.

Anotação de Vídeo e Técnicas de Processamento

Dados de qualidade sustentam o desempenho do modelo. Anotação de vídeo envolve rotular objetos, ações e cenas para que os modelos possam aprender. Anotação manual oferece alta qualidade, mas não escala bem. Ferramentas automatizadas aceleram o processo propagando rótulos em frames adjacentes e sugerindo posições candidatas de caixas delimitadoras. Active learning fecha o ciclo ao pedir que humanos revisem apenas exemplos incertos.

Pré-processamento afeta o pipeline de treinamento. Passos típicos incluem extração de frames, redimensionamento, normalização e augmentação. Extração de frames converte um arquivo de vídeo em frames ordenados em um fluxo de vídeo. Redimensionamento equilibra o tamanho de entrada do modelo com orçamentos de computação. Normalização alinha distribuições de pixels para que redes profundas concorram mais rápido. Augmentação simula variações como mudanças de brilho ou pequenas rotações para aumentar robustez.

A anotação pode ser específica da tarefa. Dense video captioning combina detecção, segmentação temporal e geração de linguagem natural para criar resumos. Para tarefas clássicas de visão computacional, anotação e treinamento de modelos focam na precisão da caixa delimitadora e nos rótulos de classe. Rótulos de alta qualidade de objetos em um vídeo ajudam modelos a aprender localização precisa de objetos, o que melhora tarefas downstream como busca forense. Para mais sobre busca prática em acervos, veja como busca forense suporta investigações busca forense em aeroportos.

Manter corpora rotulados é essencial para aprendizado supervisionado. Curadoria de datasets de vídeo deve refletir o ambiente alvo. É por isso que soluções on-prem, onde os dados nunca saem do local, são atraentes para organizações com necessidades de conformidade. visionplatform.ai oferece fluxos de trabalho para melhorar modelos pré-treinados com dados específicos do site e para construir modelos do zero quando necessário. Essa abordagem híbrida reduz o tempo de re-treinamento e melhora a precisão para casos de uso específicos como contagem de pessoas e análise de densidade de multidões contagem de pessoas.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Análise de Vídeo em Tempo Real com Modelos de IA

Requisitos de tempo real moldam o desenho e a implantação do modelo. Em muitos cenários operacionais, sistemas precisam processar 30 frames por segundo para acompanhar feeds ao vivo. Throughput e latência então se tornam restrições de primeira ordem. Arquiteturas leves e modelos quantizados ajudam a atingir metas de desempenho em hardware de borda como NVIDIA Jetson. O trade-off frequentemente é entre precisão e velocidade: otimizar por um pode reduzir o outro.

Inferência na borda reduz uso de rede e suporta arquiteturas alinhadas ao EU AI Act que preferem processamento on-prem. visionplatform.ai oferece Vision Language Models e agentes on-prem que raciocinam sobre gravações locais, o que mantém o vídeo bruto no ambiente e reduz risco de conformidade. Um modelo de IA projetado para a borda frequentemente usará menos parâmetros, poda agressiva e aritmética de precisão mista para alcançar os frames por segundo requeridos mantendo precisão aceitável.

Análise de vídeo em tempo real também exige desenho robusto de sistema. Processar um feed de vídeo bruto envolve decodificação, pré-processamento de frames, passagem dos frames por um pipeline de IA e produção de alarmes ou descrições textuais. Sistemas usam buffering e pipelines assíncronos para evitar interrupções. Eles também priorizam quais feeds analisar em alta fidelidade e quais amostrar em taxas menores. Para alguns cenários de vigilância, um modelo de detecção sinaliza eventos candidatos e uma segunda fase de IA verifica e explica-os, reduzindo falsos alarmes e sobrecarga do operador.

Operadores ganham com IA que explica suas saídas. Por exemplo, VP Agent Reasoning correlaciona detecções com logs de VMS e controle de acesso, e fornece contexto para cada alerta. Isso reduz o tempo por alarme e apoia decisões mais rápidas. Tempo real não significa apenas velocidade; também significa contexto acionável quando segundos contam. Para mais sobre detecções em tempo real vinculadas a tarefas específicas, veja soluções de detecção de intrusões que integram análises em tempo real detecção de intrusões.

Aplicações, Insights e Desafios no Entendimento de Vídeo

Aplicações de entendimento de vídeo abrangem segurança, operações, varejo e esportes. Em segurança, sistemas detectam acesso não autorizado e disparam fluxos de trabalho que orientam respostas de operadores. No varejo, analytics medem tempo de permanência e trajetórias de clientes. No esporte, treinadores obtêm destaques automatizados e feedback de técnica. Essa ampla gama de aplicações se beneficia quando modelos extraem características dos dados de vídeo e resumem eventos para tomadores de decisão humanos.

Insights de vídeo incluem padrões de comportamento, detecção de tendências e alertas de anomalia. Sistemas automatizados detectam anomalias aprendendo padrões normais e sinalizando desvios. Detecção de anomalia em um site de produção pode procurar desvios de processo ou pessoas em zonas restritas. A combinação de detecção de objetos e rastreamento com agentes de raciocínio ajuda a garantir que alertas tragam contexto em vez de sinais brutos.

Apesar do progresso, desafios em vídeo permanecem. Detecção de deep-fake e manipulação é urgente porque discurso político e notícias podem ser alvo de forjamentos realistas. Pesquisas mostram que humanos têm dificuldade em detectar manipulações hiper-realistas, o que aumenta a necessidade de assistência algorítmica e pipelines de verificação robustos veja o estudo. Fusão multi-câmera, privacidade e viés de dataset complicam implantações. Sistemas devem evitar vazar conteúdo de vídeo e devem respeitar regulações. IA on-prem e configurações transparentes ajudam a endereçar algumas dessas preocupações.

Aplicações no mundo real também exigem integração. visionplatform.ai conecta detecções e operações expondo eventos como entradas estruturadas para agentes de IA, permitindo que VP Agent Actions pré-preencha relatórios de incidente e recomende fluxos de trabalho. Essa abordagem orientada por agentes reduz a carga cognitiva do operador e escala o monitoramento com autonomia opcional. Para exemplos operacionais adicionais como detecção de EPI e classificação de veículos, veja páginas de detecção de EPI detecção de EPI e detecção e classificação de veículos.

FAQ

What is video understanding and how does it differ from simple detection?

O entendimento de vídeo refere-se à extração de significado semântico, contexto e intenção de sequências visuais. Detecção simples foca em localizar e rotular objetos dentro de um frame, enquanto o entendimento conecta eventos ao longo do tempo e explica sua importância.

How does AI improve real-time monitoring in control rooms?

A IA acelera a detecção e reduz buscas manuais convertendo eventos visuais em descrições pesquisáveis. Agentes de IA podem verificar alarmes, sugerir ações e até pré-preencher relatórios para apoiar operadores.

What are common models used for object detection?

Modelos populares incluem Faster R-CNN para precisão e YOLO para velocidade. Ambos fornecem caixas delimitadoras e rótulos de classe, e variantes são otimizadas para implantação na borda ou na nuvem.

Why is annotation important for video models?

A anotação fornece exemplos rotulados que modelos supervisionados usam para aprender. Anotação de alta qualidade de objetos e ações melhora a localização de objetos e reduz falsos positivos durante a inferência.

Can systems detect actions like fighting or loitering?

Sim. Modelos de detecção de ação e classificação de vídeo identificam quando uma ação está sendo realizada. Fluxos de trabalho especializados combinam detecção com modelos temporais para sinalizar comportamentos como permanência suspeita ou agressão.

How do systems handle motion blur and low-light conditions?

Pré-processamento robusto e augmentação de dados durante o treinamento ajudam modelos a generalizar. Agregação de múltiplos frames e fusão de sensores também melhoram o desempenho quando frames individuais estão ruidosos.

Are there privacy concerns with AI for video?

Sim. Armazenar e processar dados de vídeo levanta questões de privacidade e conformidade. IA on-prem e logging transparente reduzem exposição e ajudam a atender requisitos regulatórios.

What is the role of object tracking in surveillance?

O rastreamento de objetos relaciona detecções entre frames para manter identidade e trajetória. Essa persistência melhora busca forense e reduz alertas repetidos para o mesmo objeto.

How does dense video captioning help users?

Dense video captioning gera resumos textuais para segmentos, tornando acervos pesquisáveis e encurtando o tempo de investigação. Ele faz a ponte entre detecções brutas e descrições legíveis por humanos.

What is a practical first step to add AI to existing cameras?

Comece executando um modelo de detecção leve em filmagens representativas para medir precisão e throughput. Em seguida, melhore iterativamente modelos com anotações específicas do site e integre agentes de raciocínio para alertas com contexto.