Compreendendo o papel do vídeo na IA multimodal

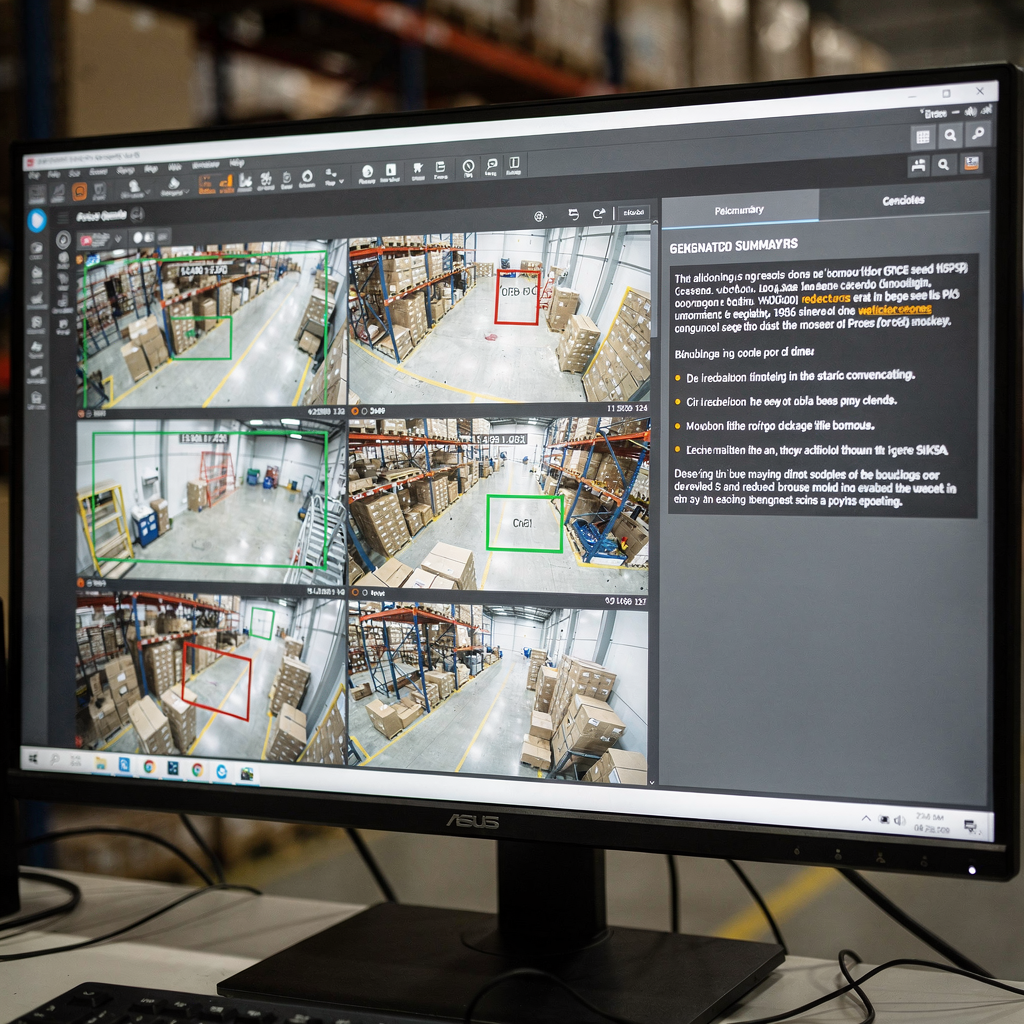

Primeiro, o vídeo é o sensor mais rico para muitos problemas do mundo real. Além disso, o vídeo carrega sinais espaciais e temporais. Em seguida, pixels visuais, movimento e áudio se combinam para formar longas sequências de quadros que exigem manuseio cuidadoso. Portanto, os modelos devem capturar detalhes espaciais e dinâmicas temporais. Além disso, eles devem processar sequências de forma eficiente. Por exemplo, um operador da sala de controle precisa de um resumo claro e conciso de horas de filmagem. Por exemplo, sistemas modernos convertem streams em texto pesquisável e legendas, e então em ações. Essa mudança permite que os operadores passem de detecções brutas para suporte à decisão. Além disso, a visionplatform.ai adiciona uma camada de raciocínio que vincula análises ao vivo à linguagem humana para acelerar decisões e reduzir etapas manuais.

No entanto, capturar dependências temporais continua sendo um desafio-chave. Enquanto isso, segmentação de cena, detecção de eventos e inferência narrativa exigem técnicas diferentes. Além disso, a detecção de limites de corte deve ser executada antes de análises de nível superior. Em seguida, detectores de eventos devem identificar eventos específicos, como permanência suspeita ou intrusão. Você pode ler sobre busca forense integrada em implantações reais para mais contexto sobre como os sistemas dão suporte aos operadores busca forense em aeroportos. Depois, os modelos devem mapear eventos detectados para respostas naturais. Por exemplo, um VP Agent pode explicar por que um alarme foi acionado e o que fazer em seguida.

Além disso, abordagens generativas enriquecem a compreensão visual. Por exemplo, métodos de difusão e transformers permitem que um modelo imagine quadros intermediários plausíveis ou ligações causais. Além disso, IA generativa pode produzir legendas de várias frases e Árvores de Legendas para cenas complexas. Pesquisas recentes e avanços em avaliação em larga escala mostram melhorias rápidas na compreensão de imagens e vídeos conforme resumido pelos workshops da CVPR. Portanto, combinar encoders visuais com decodificadores de grande linguagem torna-se uma estratégia eficaz. Finalmente, essa abordagem ajuda os sistemas a fornecer resumos concisos para operadores e agentes automatizados na sala de controle.

Explorando arquiteturas de modelos para sumarização

Primeiro, encoders visuais formam a etapa de entrada. Redes neurais convolucionais ainda funcionam bem para muitas tarefas. Além disso, Vision Transformers (ViT) e transformers específicos para vídeo processam tokens espaço-temporais de quadros e clipes curtos. Em seguida, transformers de vídeo capturam movimento ao longo de uma sequência e as dinâmicas temporais relevantes. Por exemplo, variantes de ViT e atenção esparsa ajudam a escalonar para sequências de vídeo longas. Além disso, hardware da NVIDIA frequentemente acelera esses pipelines na borda ou em servidores com GPU. Você pode saber sobre padrões típicos de detecção de pessoas e implantações em sites reais através da nossa página de detecção de pessoas em aeroportos. Também, muitas equipes realizam fine-tuning do modelo com dados locais para se adaptar a especificidades do domínio.

Segundo, decodificadores de linguagem transformam características visuais em texto. Grandes decodificadores de linguagem e transformers como GPT, T5 e BART produzem descrições fluentes. Além disso, um grande modelo de linguagem pode converter sinais visuais estruturados em parágrafos coerentes e legendas. No entanto, modelos frequentemente precisam de grounding para evitar alucinações. Portanto, estratégias de fusão são críticas. Cross-attention, co-training e fusão de modelos visão-linguagem permitem que tokens visuais influenciem a geração de texto. Por exemplo, Vision Language World Models criam uma visão de mundo estruturada que suporta planejamento e narração, e permitem Árvores de Legendas para estruturar resumos conforme mostrado em trabalho recente no arXiv.

Além disso, módulos de raciocínio e técnicas generativas melhoram a qualidade da saída. Por exemplo, abordagens de difusão discreta e planejamento de sequência ajudam o modelo a raciocinar sobre cadeias causais e eventos específicos. Além disso, integrar um modelo visão-linguagem com módulos simbólicos ou de recuperação pode melhorar a factualidade e a rastreabilidade. Por exemplo, um sistema pode recuperar clipes passados para verificar uma detecção atual e então produzir uma resposta legível por humanos. Finalmente, quando arquitetos unificam encoders e decoders, eles criam uma estrutura poderosa que suporta tanto a geração de resumos quanto tarefas downstream.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Técnicas e pipeline para sumarização de vídeo

Primeiro, o pipeline tipicamente tem três etapas principais. A detecção de limites de cena vem primeiro. Em seguida, a extração de características converte quadros em tokens visuais. Depois, a síntese de resumo produz texto condensado ou clipes de destaque. Além disso, essas etapas podem rodar online ou offline, e equilibram latência com precisão. Por exemplo, sistemas em tempo real priorizam inferência eficiente, enquanto analisadores offline podem usar transformers mais pesados para melhor contexto. Portanto, os projetistas escolhem arquiteturas e hardware com cuidado. Na prática, a visionplatform.ai suporta processamento on-prem para manter vídeo e modelos dentro dos limites do site, e isso melhora conformidade e controle.

Além disso, a engenharia de prompts guia a sumarização sensível ao contexto com decodificadores generativos. Por exemplo, um prompt descrevendo o comprimento desejado, ênfase ou público pode moldar o texto que o modelo produz. Além disso, um prompt descrevendo a visão da câmera ou uma tarefa ajuda um grande modelo de linguagem a produzir legendas e respostas mais úteis. Em seguida, fluxos de trabalho com recuperação aumentada permitem que o sistema consulte clipes históricos ou documentos de procedimento antes de produzir uma resposta. Por exemplo, o VP Agent Search usa consultas em linguagem natural para encontrar incidentes passados e apoiar trabalho forense rápido busca forense em aeroportos. Além disso, prompts zero-shot ou few-shot permitem implantação rápida para novas tarefas sem muitos rótulos.

Processamento em tempo real versus offline apresenta compromissos. Sistemas em tempo real exigem encoders eficientes e atenção esparsa. Além disso, podem usar recuperação aproximada para acelerar decisões. Enquanto isso, o processamento offline pode realizar raciocínio temporal mais complexo e modelagem causal. Portanto, os pipelines frequentemente misturam ambos os modos. Finalmente, a integração de módulos temporais e grafos causais ajuda o pipeline a raciocinar sobre sequências e por que os eventos ocorrem. Essa abordagem melhora a capacidade de gerar resumos concisos e recomendações claras para o operador ou agente de IA.

Recursos de conjuntos de dados e anotação para sumarização de vídeo

Primeiro, conjuntos de dados públicos continuam essenciais para treinamento e benchmarking. Escolhas padrão incluem SumMe, TVSum, ActivityNet e YouCook2. Além disso, esses conjuntos de dados fornecem diferentes formatos de anotação, como clipes de destaque, limites temporais e legendas descritivas. Em seguida, a escolha da anotação afeta fortemente as tarefas downstream. Por exemplo, modelos treinados em dados ricos em legendas aprendem a produzir descrições de várias frases, enquanto rótulos baseados em destaques treinam modelos para selecionar clipes salientes. Além disso, geração de dados sintéticos e aumento podem mitigar a escassez de dados ao expandir a diversidade.

No entanto, viés em conjuntos de dados é uma preocupação importante. Além disso, mudanças de domínio entre conjuntos públicos e sites operacionais reduzem o desempenho do modelo. Portanto, adaptação no local e fine-tuning do modelo com rótulos locais é comum. Por exemplo, a visionplatform.ai suporta fluxos de trabalho de modelos personalizados para que equipes possam melhorar um modelo pré-treinado com suas próprias classes. Essa abordagem reduz falsos positivos e aumenta a capacidade prática do modelo no campo. Em seguida, os formatos de anotação variam. Legendas fornecem rótulos semânticos densos, enquanto limites temporais marcam pontos de início e fim para eventos específicos.

Além disso, gerenciar a diversidade dos conjuntos de dados importa para avaliação. Por exemplo, incluir imagens aéreas, internas e de câmeras montadas em veículos gera características visuais mais robustas. Além disso, aproveitar clipes sintéticos pode ajudar com eventos raros. Você pode consultar revisões acadêmicas para tendências gerais de conjuntos de dados e práticas de benchmark que fazem uma visão geral do campo. Finalmente, uma estratégia mista que combina conjuntos públicos, aumento sintético e rótulos específicos do local muitas vezes produz o melhor desempenho operacional.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Métricas de benchmark e avaliação para sumarização de vídeo

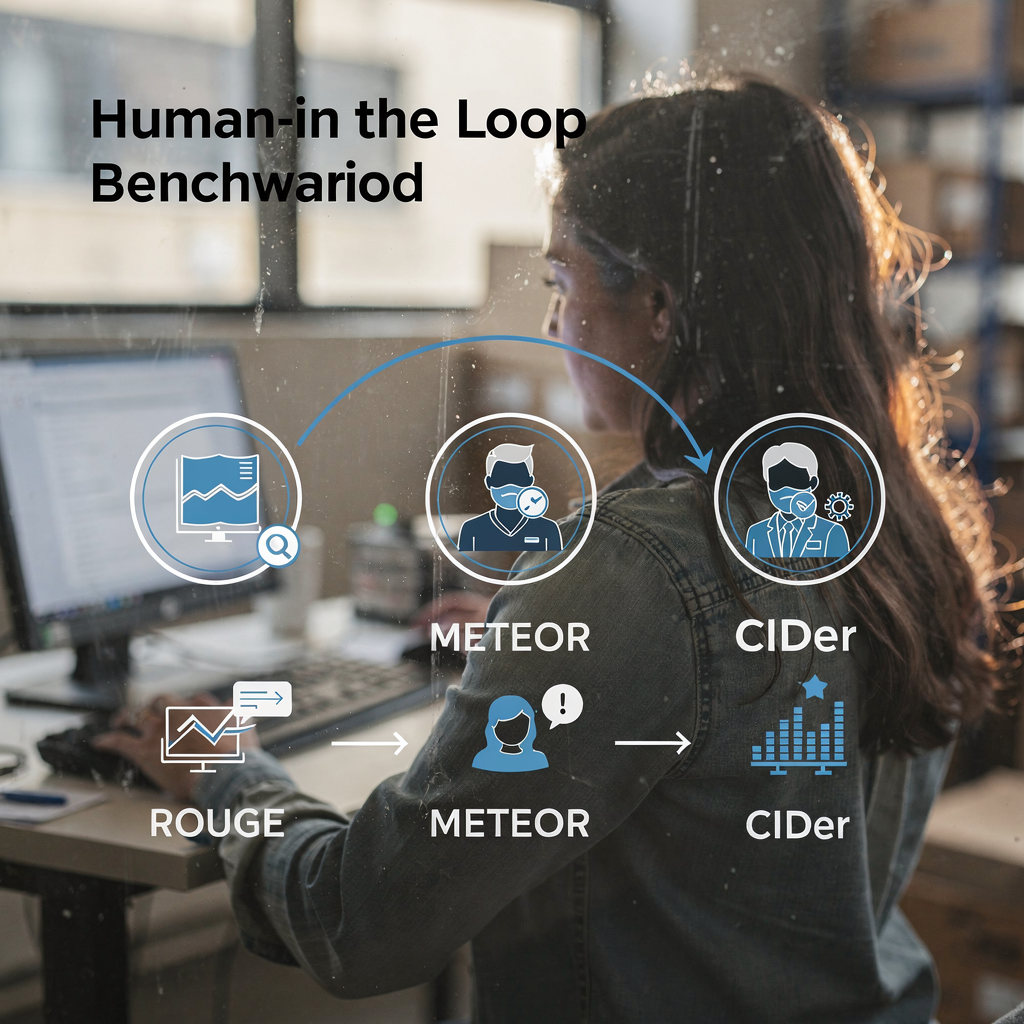

Primeiro, a avaliação usa tanto métricas automatizadas quanto julgamentos humanos. Métricas automatizadas padrão incluem ROUGE, METEOR e CIDEr. Além disso, scores F1 e métricas de recall medem a qualidade da seleção de clipes. Em seguida, suítes de benchmark como VideoSumBench, VATEX e YouSumm organizam tarefas e mantêm conjuntos de teste reservados. Por exemplo, pesquisas recentes listam mais de quarenta benchmarks visão-linguagem que abrangem tarefas imagem-texto e vídeo-texto, e acompanham o progresso em vários eixos de acordo com a análise dos workshops da CVPR. Além disso, resumos do ICLR sobre trabalho Vision-Language-Action destacam ganhos significativos em tarefas temporais conforme discutido em resumos da comunidade.

No entanto, métricas não capturam tudo. Além disso, scores automatizados podem não avaliar legibilidade e utilidade operacional. Portanto, avaliação alinhada a humanos permanece crítica. Por exemplo, operadores da sala de controle devem testar se um resumo os ajuda a verificar um alarme e decidir uma ação. Na prática, o VP Agent Reasoning avalia explicações em diversas fontes e então entrega uma resposta ranqueada. Além disso, sistemas que suportam recuperação e proveniência ajudam avaliadores a julgar factualidade.

Em seguida, tendências de desempenho mostram avanços constantes. Além disso, alguns VLMs agora atingem alta acurácia em benchmarks de classificação de eventos curtos e legendagem. Por exemplo, pesquisas em larga escala documentam que modelos de ponta frequentemente excedem 80% em tarefas específicas de identificação de eventos relatadas em revisões da comunidade. Finalmente, limitações dos benchmarks atuais motivam novos frameworks com humanos no loop e testbeds mais diversos. Por exemplo, repositórios como IEEE Xplore e arXiv hospedam pesquisas e críticas que clamam por melhor alinhamento e práticas de avaliação. Assim, a comunidade continua a atualizar métricas e conjuntos de dados para refletir necessidades operacionais.

Navegação orientada a tarefas na sumarização de vídeo

Primeiro, defina as tarefas do usuário claramente. Por exemplo, recuperação, navegação e exploração interativa exigem estilos de sumarização diferentes. Além disso, consultas de recuperação demandam respostas concisas e marcadores temporais precisos. Por exemplo, busca e sumarização de vídeo devem retornar o clipe mais relevante e uma legenda ou resposta curta. Você pode melhorar o desempenho de recuperação com busca em linguagem natural sobre legendas anotadas e metadados de evento, como o VP Agent Search demonstra busca forense em aeroportos. Em seguida, fluxos de navegação enfatizam clipes curtos de destaque e texto fácil de percorrer.

Além disso, sumarização interativa suporta controles orientados pelo usuário e ciclos de feedback. Por exemplo, um operador pode solicitar um resumo mais longo ou mais curto, ou fazer perguntas de acompanhamento. Nesse caso, um modelo visão-linguagem, combinado com um grande modelo de linguagem, pode responder a consultas contextuais e refinar o resumo. Além disso, VLMs multitarefa podem combinar sumarização com perguntas e respostas, marcação e recuperação. Por exemplo, um agente de IA pode tanto marcar atividade suspeita quanto preparar relatórios de incidente. Além disso, o VP Agent Actions pode pré-preencher relatórios de incidente e recomendar próximos passos.

Em seguida, direções futuras apontam para resumos adaptativos e personalizados. Além disso, sistemas aprenderão preferências dos usuários e ajustarão o nível de detalhe. Portanto, a UX deve suportar controles rápidos e proveniência clara. Além disso, agentes agirão dentro de fluxos de trabalho com permissões para permitir automação sem comprometer a auditabilidade. Finalmente, o objetivo é unificar detecção, explicação e ação para que câmeras se tornem sensores operacionais. Essa solução melhora a capacidade do operador e reduz a carga cognitiva em ambientes em tempo real.

Perguntas Frequentes

O que é um modelo visão-linguagem e como ele se aplica à sumarização de vídeo?

Um modelo visão-linguagem funde encoders visuais com decodificadores de linguagem para produzir texto a partir de imagens ou vídeo. Além disso, ele pode gerar legendas, respostas e resumos curtos que ajudam operadores e agentes a entenderem rapidamente o conteúdo do vídeo.

Como os VLMs lidam com raciocínio temporal em vídeos longos?

Os VLMs usam transformers temporais, atenção esparsa e modelos de sequência para capturar dependências entre quadros. Além disso, camadas de planejamento e Árvores de Legendas podem estruturar eventos para melhorar o raciocínio causal.

Quais conjuntos de dados são padrão para treinar sistemas de sumarização de vídeo?

Conjuntos comuns incluem SumMe, TVSum, ActivityNet e YouCook2, que fornecem clipes de destaque, limites temporais e legendas. Além disso, equipes frequentemente aumentam conjuntos públicos com dados sintéticos e específicos do site para cobrir eventos raros.

Quais métricas avaliam a qualidade dos resumos gerados?

Métricas automatizadas incluem ROUGE, METEOR, CIDEr e F1 para seleção de clipes. No entanto, avaliação humana é essencial para julgar legibilidade, utilidade e fidelidade operacional.

Os sistemas podem realizar sumarização em tempo real em escala?

Sim, com encoders eficientes e estratégias de recuperação, os sistemas podem resumir streams ao vivo. Além disso, processamento na borda e implantação on-prem ajudam a atender requisitos de latência e conformidade.

Que papel os prompts desempenham na sumarização guiada?

Prompts direcionam o decodificador para estilos, comprimentos ou focos específicos, e permitem adaptação zero-shot ou few-shot. Além disso, engenharia de prompts ajuda decodificadores de grande linguagem a produzirem legendas e respostas mais sensíveis ao contexto.

Como os agentes interagem com os resumos para apoiar os operadores?

Agentes podem verificar alarmes, pré-preencher relatórios e recomendar ações com base no vídeo resumido e metadados relacionados. Além disso, fluxos de trabalho de agentes reduzem o tempo por alarme e melhoram a consistência.

Quais são as limitações comuns dos benchmarks atuais?

Os benchmarks frequentemente não capturam medidas subjetivas como utilidade e clareza, e raramente testam raciocínio temporal de longo alcance. Portanto, são necessários testbeds alinhados a humanos e mais diversos para avaliar melhor o desempenho operacional.

O processamento on-prem é importante para sistemas de vídeo empresariais?

Sim, o processamento on-prem preserva o controle dos dados e ajuda a atender regulações como o EU AI Act. Além disso, reduz a dependência de nuvem e mantém vídeos sensíveis dentro do ambiente do cliente.

Como as equipes podem melhorar a acurácia do modelo para um site específico?

As equipes devem ajustar finamente o modelo com dados rotulados do site e usar fluxos de trabalho personalizados para adicionar classes e regras. Além disso, feedback contínuo de operadores e agentes ajuda o sistema a se adaptar e a apresentar melhor desempenho ao longo do tempo.