modelos de linguagem e vlms para suporte à decisão do operador

Modelos de linguagem e VLMs ficam no centro do suporte à decisão moderno para operadores que lidam com sistemas complexos. Primeiro, modelos de linguagem descrevem uma classe de sistemas que predizem texto e seguem instruções. Em seguida, VLMs combinam entradas visuais com raciocínio textual para que um sistema possa interpretar imagens e responder perguntas. Por exemplo, modelos visão-linguagem podem relacionar uma imagem a um relatório e então explicar por que uma detecção é importante. Além disso, sistemas multimodais superam sistemas de modalidade única em muitos benchmarks. De fato, modelos multimodais pré-treinados apresentam até um ganho de até 30% em tarefas de VQA, o que importa quando um operador precisa fazer perguntas rápidas e direcionadas.

Operadores precisam tanto de raciocínio visual quanto textual porque nenhum fluxo único captura todo o contexto. Primeiro, uma câmera pode ver um evento. Depois, logs e procedimentos fornecem o que fazer em seguida. Assim, um modelo combinado que trate entradas visuais e textuais pode interpretar a cena e correlacioná-la com regras, procedimentos ou padrões históricos. Além disso, essa fusão de dados visuais e textuais ajuda a reduzir falsos positivos e melhora a velocidade de verificação. Por exemplo, pesquisas em diagnósticos de emergência encontraram até uma melhoria de 15% na acurácia quando imagens foram combinadas com contexto textual em cenários agudos.

Em operações, a capacidade de buscar e recuperar é crítica. visionplatform.ai transforma feeds de câmera em conhecimento pesquisável para que operadores encontrem clipes relevantes com consultas simples. Por exemplo, o recurso VP Agent Search permite que um humano peça por um incidente passado em palavras comuns e obtenha resultados precisos; isso faz a ponte entre detecção tradicional e raciocínio humano. Além disso, VLMs possibilitam resumos automáticos e linhas do tempo de eventos. Ademais, um operador humano pode solicitar uma justificativa em linguagem natural para uma saída do modelo; essas explicações em linguagem natural ajudam na confiança e na verificação. Finalmente, VLMs com sistemas robóticos podem ser usados para inspecionar equipamentos ou guiar um braço robótico durante manutenção remota, permitindo intervenções mais seguras e rápidas.

vision language models for agents in the space domain

Agentes no domínio espacial estão começando a usar modelos visão-linguagem para aprimorar a consciência situacional. Primeiro, agentes operadores no espaço podem analisar imagens de satélites e cargas. Em seguida, modelos visão-linguagem como auxiliares de operador ajudam a identificar anomalias, detritos espaciais ou falhas em instrumentos. Por exemplo, em benchmarks de detecção de anomalias, VLMs mostraram até um aumento de 15% na acurácia quando metadados contextuais foram incluídos. Além disso, grandes modelos de linguagem adicionam planejamento e seguimento de instruções aos pipelines visuais, o que permite raciocínio situacional de ponta a ponta para equipes de missão.

Os casos de uso variam por todo o setor espacial. Primeiro, equipes de inspeção de satélites usam VLMs para vasculhar imagens em busca de danos em painéis ou impactos de micrometeoritos. Segundo, sistemas de detecção de detritos sinalizam fragmentos e classificam ameaças a um ativo em órbita. Terceiro, fluxos de trabalho de inspeção de carga combinam análise visual com telemetria para decidir se programar uma operação corretiva. Além disso, esses sistemas operam dentro de uma arquitetura restrita onde largura de banda e latência limitam o que pode ser enviado para a Terra. Portanto, pré-processamento a bordo e seleção inteligente de dados tornam-se essenciais. Em um contexto de software e hardware, as equipes devem decidir onde executar os modelos: em processadores de borda do satélite ou em servidores em solo durante janelas limitadas de contato. Por exemplo, um modelo pequeno a bordo pode pontuar quadros e enviar apenas entradas sinalizadas para o solo, o que reduz o volume de telemetria.

Testes em ambientes de simulação desempenham papel fundamental antes do lançamento. Além disso, uma simulação realista ajuda a validar modelos em anomalias sintéticas e condições raras. Por exemplo, equipes usam um conjunto de dados de modos de falha anotados e um ambiente de simulação para testar agentes sob estresse. Em seguida, validação com intervenção humana ajuda a garantir que as saídas sejam acionáveis e alinhadas com procedimentos. Finalmente, planejadores de missão valorizam arquiteturas que equilibram computação, energia e robustez para que os modelos permaneçam confiáveis durante missões prolongadas.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

real-time AI integrate vlms with computer vision

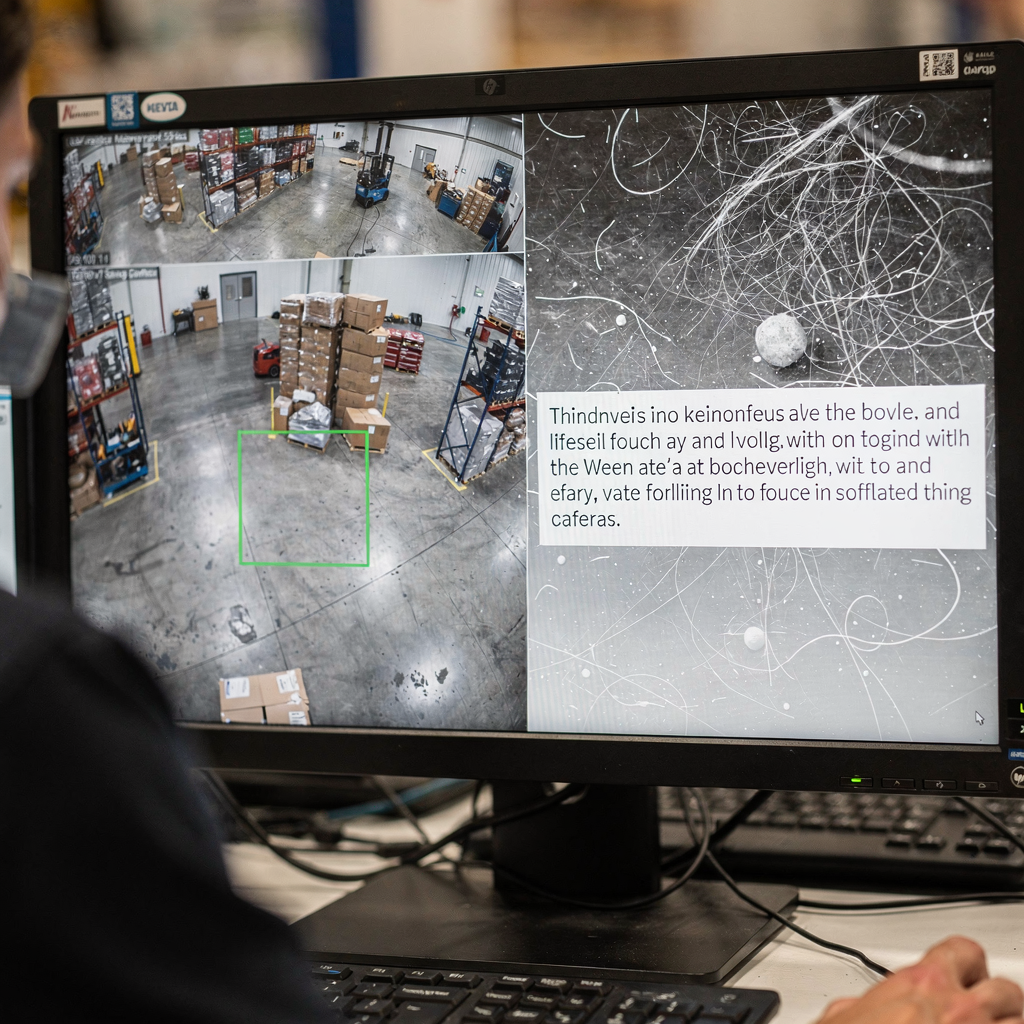

A arquitetura do sistema deve conectar sensores ao raciocínio. Primeiro, um pipeline típico flui câmera ou sensor → pré-processamento de visão computacional → inferência VLM → ação. Além disso, módulos de CV lidam com detecção, rastreamento e filtragem básica. Depois, VLMs acrescentam interpretação e respostas contextuais. Para necessidades em tempo real, muitas equipes processam feeds de câmera ao vivo a 30 fps e enviam quadros pré-processados a um VLM que retorna respostas em menos de um segundo. Por exemplo, poda cuidadosa e quantização de modelos permitem processamento de stream com baixa latência. Além disso, visionplatform.ai oferece suporte a inferência on-prem para que vídeo e modelos nunca saiam do local, o que ajuda a atender requisitos de conformidade.

Odesenvolvimento de borda exige eficiência de modelo. Primeiro, poda, destilação e quantização reduzem o tamanho do modelo sem sacrificar capacidades críticas. Depois, implantar um VLM compacto em servidores GPU ou aceleradores de borda como NVIDIA Jetson torna possível inferência em menos de um segundo. Também, as melhores práticas incluem dimensionamento de lotes para corresponder ao throughput, pipelines assíncronos para evitar bloqueios, e detectores de fallback para manter o tempo de atividade. Para robótica, percepção em tempo real deve tolerar quadros perdidos e entradas ruidosas. Portanto, o sistema deve agregar evidências ao longo de quadros e usar limiares de confiança para decidir quando pedir intervenção de um operador humano.

Integração requer APIs claras e formatos de evento. visionplatform.ai expõe eventos via MQTT e webhooks para que salas de controle possam conectar agentes de IA a fluxos de trabalho VMS existentes. Além disso, ferramentas de busca e ações pré-programadas podem ser ligadas a alertas verificados para reduzir passos manuais. Por fim, as equipes devem medir custo computacional, latência de classificação e tempo de ponta a ponta até a ação. Esse monitoramento sistemático ajuda a iterar na arquitetura e manter a resiliência operacional durante cargas pesadas.

bridging the gap: vision language models as operator to leverage decisions

Explicabilidade está no cerne da confiança. Primeiro, operadores precisam de mapas de saliência e de justificativas em linguagem natural para entender por que um modelo fez uma afirmação. Além disso, um especialista citado capturou esse requisito: “The explainability of model recommendations is not just a technical challenge but a fundamental requirement for adoption in clinical and operational settings” (source). Em seguida, combinar sobreposições visuais com uma breve justificativa em linguagem natural ajuda o operador a validar rapidamente uma recomendação. Por exemplo, o recurso VP Agent Reasoning correlaciona deteções, descrições VLM e logs VMS para explicar validade e impacto.

Estudos de trabalho homem–máquina mostram ganhos mensuráveis. Primeiro, experimentos indicam uma redução de aproximadamente 20% nos erros do operador quando a IA fornece contexto e recomendações durante tarefas de alta pressão. Em seguida, esses ganhos decorrem da redução da carga cognitiva e de ciclos de verificação mais rápidos. Além disso, processos com intervenção humana preservam a supervisão em decisões de alto risco enquanto permitem automação para tarefas rotineiras. Por exemplo, VP Agent Actions pode pré-preencher relatórios de incidente e sugerir próximos passos enquanto deixa a aprovação final para operadores humanos.

Governança e políticas importam. Primeiro, operadores devem conhecer a proveniência dos dados e trilhas de auditoria para aceitar sugestões automatizadas. Depois, um quadro de governança deve definir permissões, regras de escalonamento e pontos de validação. Além disso, sistemas devem suportar validação contínua e pipelines de re-treinamento para manter a robustez conforme os ambientes evoluem. Finalmente, organizações devem avaliar modelos com ferramentas de código aberto quando possível e manter logs de validação para satisfazer padrões como ITAR ou GDPR quando aplicáveis. Isso constrói a confiança do operador e apoia automação mais segura em operações ao vivo.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

GenAI deployment in the public sector to integrate vlms

Agências do setor público estão ativamente avaliando GenAI e VLMs para defesa, serviços de emergência e programas espaciais. Primeiro, diretrizes políticas em muitos países incentivam IA on-prem e auditável para atender necessidades de conformidade e segurança. Em seguida, agências exigem governança clara dos dados e devem alinhar-se com ITAR, GDPR e regras de compras. Por exemplo, alguns ensaios nacionais usam VLMs em redes seguras onde o vídeo nunca sai do local para garantir conformidade com regras locais. Além disso, planos de implantação normalmente combinam pilotos de campo com testes controlados em operação.

Casos de uso em defesa e serviços de emergência incluem monitoramento de perímetros, busca forense e relatórios automatizados. Capacidades forenses podem pesquisar filmagens históricas usando linguagem natural; veja nosso recurso de busca forense para um exemplo de como a busca pode funcionar em um contexto aeroportuário (busca forense em aeroportos). Além disso, detecção de anomalia de processo ajuda equipes a encontrar comportamentos atípicos antes que escalem; mais contexto está disponível em nossa página de detecção de anomalias de processo (detecção de anomalias de processo em aeroportos).

Ensaios em programas espaciais nacionais frequentemente focam em saúde do satélite e monitoramento de detritos. Primeiro, um satélite pode gerar grande volume de dados visuais mas apenas downlink limitada. Portanto, agências usam filtros a bordo e VLMs baseados em solo para priorizar telemetria. Além disso, implantações no setor público devem considerar compras, auditoria e manutenção de longo prazo. visionplatform.ai atua como integrador, permitindo que salas de controle mantenham vídeo e modelos on-prem enquanto adicionam fluxos de trabalho conduzidos por agentes que reduzem a carga de operadores e suportam automação. Finalmente, um rollout em etapas que inclui estudos pilotos, validação e escalonamento iterativo ajuda a alinhar partes interessadas e institucionalizar boas práticas.

advance real-world domain integration

Capacidades de próxima geração vão focar em aprendizado contínuo, adapters e prompt tuning para melhorar adaptabilidade. Primeiro, módulos adaptadores permitem que equipes atualizem um modelo para um novo site sem re-treinar toda a rede. Depois, pipelines de aprendizado contínuo adaptam modelos ao longo do tempo enquanto limitam o esquecimento catastrófico. Além disso, prompt tuning e extensões multimodais permitem que um único sistema lide com novas tarefas com dados rotulados mínimos. Por exemplo, fine-tuning em um conjunto de dados direcionado melhora a acurácia específica do site e reduz falsos positivos.

Desafios permanecem. Primeiro, rotular conjuntos de dados para eventos raros é caro, e orçamentos de computação restringem com que frequência equipes podem re-treinar. Em seguida, robustez sob variância operacional — iluminação, clima, ângulos de câmera — requer testes sistemáticos. Portanto, um roteiro prático começa com pequenos pilotos, seguido por rollout incremental e monitoramento contínuo. Além disso, equipes devem incluir critérios claros de validação e um plano de iteração. Por exemplo, um piloto pode avaliar resultados experimentais em cenários controlados e depois estender para feeds de câmera ao vivo para validação.

Governança e métricas completam o ciclo. Primeiro, monitore acurácia de classificação, latência e taxa de aceitação pelo operador humano. Em seguida, acompanhe insights acionáveis e tempo até resolução para destacar benefícios operacionais. Também inclua análise de comportamento para entender como sugestões de IA alteram processos de tomada de decisão humana. Finalmente, uma abordagem metódica que combine validação técnica, testes com intervenção humana e alinhamento de políticas permitirá implantação sustentável. Como resultado, equipes podem fechar a lacuna entre pesquisa e prática e avançar uma IA operacional mais segura e adaptativa em diversos domínios.

FAQ

What are vision language models and how do they differ from language models?

Modelos visão-linguagem combinam entendimento de imagens e texto para que possam responder perguntas sobre cenas visuais. Em contraste, modelos de linguagem lidam com tarefas apenas em texto e não conseguem interpretar dados visuais sem módulos adicionais.

How do VLMS improve operator decision-making in control rooms?

VLMs convertem vídeo ao vivo em descrições textuais e resumos contextuais que operadores podem buscar e verificar. Eles reduzem a carga cognitiva correlacionando vídeo, procedimentos e logs do sistema para apresentar opções acionáveis.

Can VLMS run on local infrastructure to meet compliance needs?

Sim. Implantação on-prem mantém vídeo e modelos dentro do ambiente seguro, o que ajuda a atender constraints do GDPR e ITAR. visionplatform.ai oferece opções que evitam transferência de vídeo para a nuvem e suportam trilhas de auditoria.

Are there examples of measurable benefits from using VLMS?

Benchmarks mostram até uma melhoria de 30% em resposta a perguntas visuais e um aumento de 15% na acurácia em algumas tarefas diagnósticas quando contexto visual é pareado com texto em avaliações de referência. Estudos também relatam economia de tempo em fluxos clínicos e validação.

How do VLMS handle limited bandwidth in space missions?

Eles usam pré-processamento a bordo para pontuar quadros e enviar apenas dados ou resumos sinalizados. Essa telemetria seletiva reduz o volume de downlink mantendo a equipe em solo informada.

What explainability features should operators expect from VLMS?

Espere mapas de saliência, breves justificativas em linguagem natural e checagens cruzadas contra logs e procedimentos. Esses recursos permitem validação rápida e constroem confiança em decisões de alto risco.

How do I integrate VLMS with existing VMS platforms?

Use APIs padrão e streams de eventos como MQTT e webhooks para conectar saídas de VLMs a fluxos de trabalho VMS. Para exemplos detalhados em contextos aeroportuários, veja nossos recursos de detecção de intrusões e busca forense (detecção de intrusões, busca forense).

What governance steps are needed before deploying VLMS?

Defina permissões, trilhas de auditoria, caminhos de escalonamento e critérios de validação. Além disso, implemente monitoramento contínuo e planos de re-treinamento para manter robustez ao longo do tempo.

Can VLMS work with robotic inspection systems?

Sim. VLMs podem guiar braços robóticos ou drones interpretando entrada de câmera e fornecendo instruções contextuais relevantes. A integração com robótica permite inspeção mais segura e rotinas autônomas.

How should organisations start a rollout of VLMS?

Comece com um pequeno piloto focado em um caso de uso bem definido, colete métricas de validação e expanda a implantação de forma iterativa. Inclua revisões com intervenção humana nas fases iniciais para garantir automação segura e aceitação pelos operadores.