modelo de linguagem e modelo visão-linguagem: introdução

Um modelo de linguagem prevê texto. Em contextos de VMS, um modelo de linguagem mapeia palavras, frases e comandos para probabilidades e ações. Um modelo visão-linguagem adiciona visão a essa capacidade. Ele combina entrada visual com raciocínio textual para que operadores de VMS possam fazer perguntas e receber descrições legíveis por humanos. Esse contraste entre modelos apenas de texto e VLMs multimodais é importante para implantações práticas. Sistemas apenas de texto indexam logs, tags e transcrições. Em contraste, VLMs indexam frames, eventos e linguagem natural juntos. Por exemplo, um operador pode pesquisar “pessoa perambulando perto do portão fora do horário” e recuperar clipes correspondentes. Essa capacidade reduz o tempo gasto em revisão manual. Estudos mostram que o processamento inteligente de vídeo usando IA pode reduzir o tempo de revisão manual em até 60% [fonte]. Além disso, o mercado global de vigilância por vídeo está crescendo rapidamente. Analistas projetam um CAGR de aproximadamente 10,5% até 2030 e um mercado superior a $90 bilhões até lá [fonte]. Esses números ressaltam a demanda por VMS mais inteligentes. visionplatform.ai atende a essa necessidade adicionando um modelo visão-linguagem on-prem e fluxos de trabalho orientados por agentes. Nossa plataforma transforma detecções em contexto, raciocínio e insights acionáveis. Os operadores não veem mais apenas alertas. Eles leem situações explicadas e recebem ações sugeridas. Isso reduz a carga cognitiva e acelera as decisões. A integração de visão e texto muda a forma como as equipes pesquisam o histórico de vídeo, verificam alarmes e automatizam relatórios. Em aeroportos, por exemplo, a busca forense semântica melhora as investigações. Para leitores que querem um exemplo concreto, veja nossa solução de busca forense para aeroportos Busca forense em aeroportos. Os próximos capítulos explicam a arquitetura e as escolhas de design por trás desses sistemas, e como os vlms aprendem a mapear vídeo e linguagem em conhecimento pesquisável.

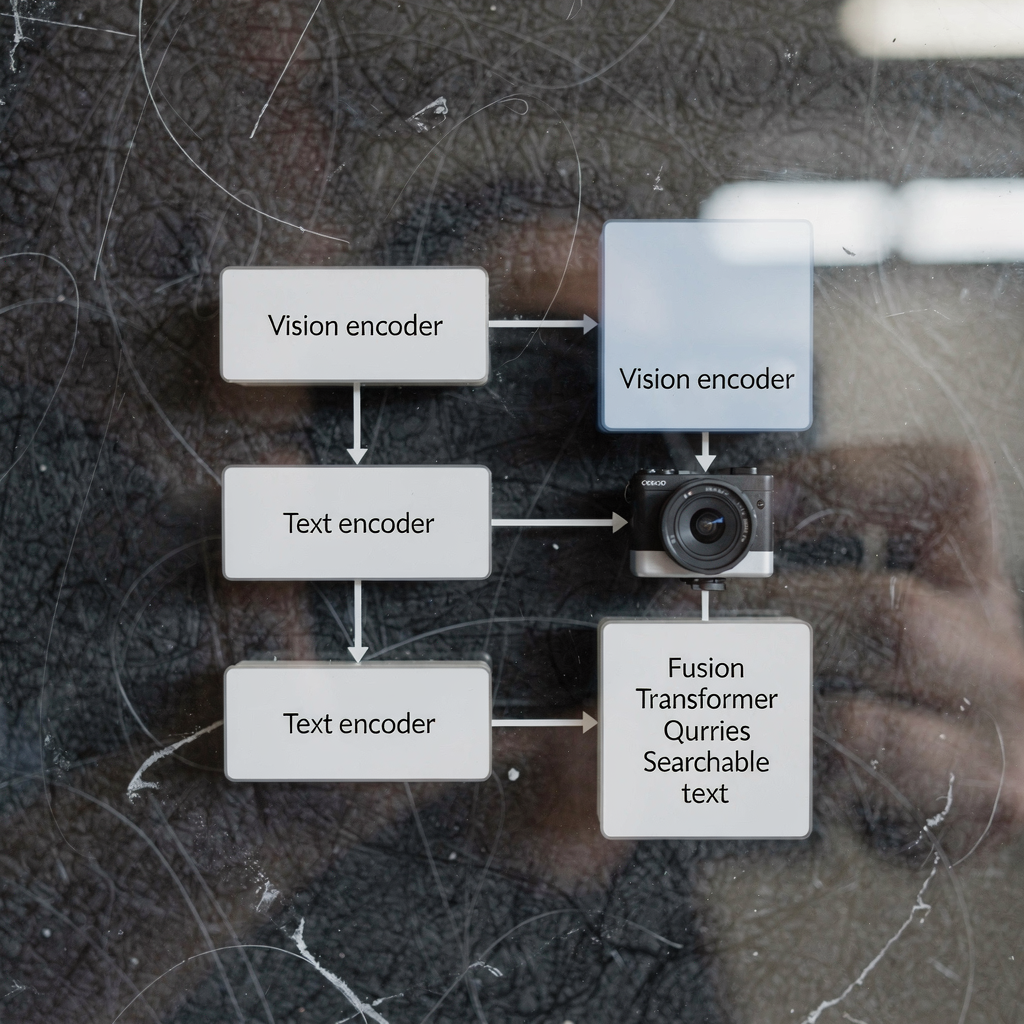

arquitetura de modelos visão-linguagem e codificador de visão: visão técnica

A arquitetura de modelos visão-linguagem tipicamente tem três componentes principais: um codificador de visão, um codificador de texto e uma camada de fusão multimodal. O codificador de visão processa frames brutos, extraindo características como formas, pistas de movimento e embeddings de objetos. O codificador de texto transforma legendas, consultas e textos de procedimento em representações vetoriais. Em seguida, uma etapa de fusão alinha tokens de imagem e texto para raciocínio conjunto. Muitos sistemas constroem essa pilha sobre um backbone transformer e usam um vision transformer como codificador de visão em alguns projetos. Modelos de codificadores duais separam fluxos visuais e textuais e usam aprendizado contrastivo para alinhar embeddings, enquanto outros desenhos usam cross-attention para integrar sinais em profundidade. A arquitetura transformer permite atenção sensível ao contexto entre tokens. Essa atenção suporta tarefas como visual question answering e geração de legendas semânticas. Em VMS de produção, latência e throughput importam. Inferência on-prem costuma usar codificadores de visão otimizados e modelos pré-treinados quantizados para reduzir o custo computacional. Tarefas visão-linguagem como geração de legendas de eventos ou detecção de anomalias exigem tanto modelagem de sequência quanto mapas de características espaciais. Um modelo foundation pode fornecer priors visuais e textuais gerais. Depois, fine-tuning específico do local adapta o modelo para uma tarefa concreta. Por exemplo, modelos como CLIP oferecem um poderoso alinhamento imagem-texto que muitos sistemas aproveitam como modelos pré-treinados. Desenvolvedores frequentemente combinam técnicas de visão computacional e linguagem natural para produzir percepção rápida e confiável. visionplatform.ai usa codificadores e camadas de fusão personalizados para expor eventos de vídeo como descrições em linguagem natural. Esse projeto permite que o VP Agent Suite ofereça VP Agent Search e VP Agent Reasoning com baixa latência. Para leitores interessados em análises ao nível de objeto, nossa solução de detecção de pessoas em aeroportos mostra como modelos de visão alimentam raciocínio de nível superior Detecção de pessoas em aeroportos.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

vlm, vlms e integração de sistemas de ia em VMS

Primeiro, esclareça os termos. Um VL M, ou vlm, refere-se a uma única instância de modelo visão-linguagem. O plural, vlms, refere-se a coleções desses modelos implantados numa plataforma. Um sistema de ia integra vlms, telemetria e regras de negócio em um VMS coeso. A integração normalmente segue três abordagens: cloud-first, on-premise e implantação na edge. Soluções cloud-first centralizam computação pesada e grandes modelos pré-treinados para escala. Implantações on-prem mantêm vídeo e modelos dentro do ambiente do cliente para conformidade. Implantações em edge empurram inferência para próximo às câmeras para latência mínima. Cada abordagem tem trade-offs. A nuvem oferece elasticidade e atualizações mais simples. A edge reduz largura de banda e baixa latência. On-prem equilibra controle e conformidade. visionplatform.ai foca por padrão em on-prem e edge, mantendo o vídeo e os modelos dentro do ambiente. Esse design alinha-se com considerações do AI Act da UE e reduz a dependência da nuvem para locais sensíveis. Um sistema de ia pode orquestrar múltiplos vlms para diferentes tarefas. Por exemplo, um vlm pode tratar detecção de pessoas, outro gerar legendas e um terceiro verificar alarmes. O sistema transmite eventos, aplica regras e expõe saídas estruturadas para agentes de IA. Esses agentes então raciocinam sobre dados do VMS para recomendar ações. VLMS podem ser encadeados de modo que um vlm que descreve um evento alimente um vlm de raciocínio. Esse padrão permite suporte decisório mais nuançado. Para monitoramento de transporte, vlms simultâneos detectam veículos, leem placas e descrevem comportamentos. Para casos de intrusão, aprendizados de um modelo de detecção de intrusões informam resposta e relatórios; veja nossa página de detecção de intrusões em aeroportos Detecção de intrusões em aeroportos. A integração também requer APIs e padrões como ONVIF e RTSP para conectar câmeras. Finalmente, fluxos de trabalho de operadores precisam de controles com humano no loop para gerenciar autonomia de forma segura.

modelo treinado e modelos de linguagem treinados: dados e pipelines de treinamento

Preparar um modelo treinado em dados vídeo-texto requer conjuntos de dados curados e pipelines em múltiplas etapas. O pipeline geralmente começa com a coleta de dados. Vídeo bruto, legendas, anotações e transcrições formam a base. Em seguida, o pré-processamento extrai frames, alinha timestamps e emparelha trechos de imagem e texto. Conjuntos de dados de treinamento para vlms devem incluir cenas diversas, ações rotuladas e legendas descritivas. Dados de treinamento para vlms frequentemente derivam de datasets públicos e filmagens proprietárias. O modelo aprende a correlacionar pixels com linguagem através de tarefas como aprendizado contrastivo, masked language modeling e geração de legendas. Modelos de linguagem treinados em legendas e transcrições fornecem priors textuais robustos. Esses componentes de linguagem pré-treinados aceleram o fine-tuning downstream. Transfer learning é comum: grandes modelos pré-treinados fornecem conhecimento geral, depois o fine-tuning direcionado adapta para uma tarefa específica. Para tarefas de VMS, o fine-tuning em anotações específicas do domínio é crucial. Por exemplo, um modelo treinado em filmagens de aeroporto aprende a reconhecer portões de embarque, filas e comportamentos relacionados a bagagens. Aumento de dados e geração de dados sintéticos ajudam onde anotações são escassas. Estágios do pipeline incluem treinamento em batch, validação e testes de implantação em dispositivos de edge ou servidores. Monitoramento durante a implantação captura drift e quedas de desempenho. Equipes frequentemente usam ciclos de aprendizagem contínua para retreinar modelos com novos eventos anotados. visionplatform.ai suporta fluxos de trabalho de modelos customizados: use um modelo pré-treinado, melhore-o com seus dados ou construa um do zero. Essa flexibilidade ajuda locais a desenvolver modelos confiáveis para alertas direcionados e busca forense. Ao treinar, os praticantes também devem gerenciar privacidade, retenção e requisitos de conformidade. Usar pipelines on-prem preserva o controlo sobre vídeos e metadados sensíveis.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

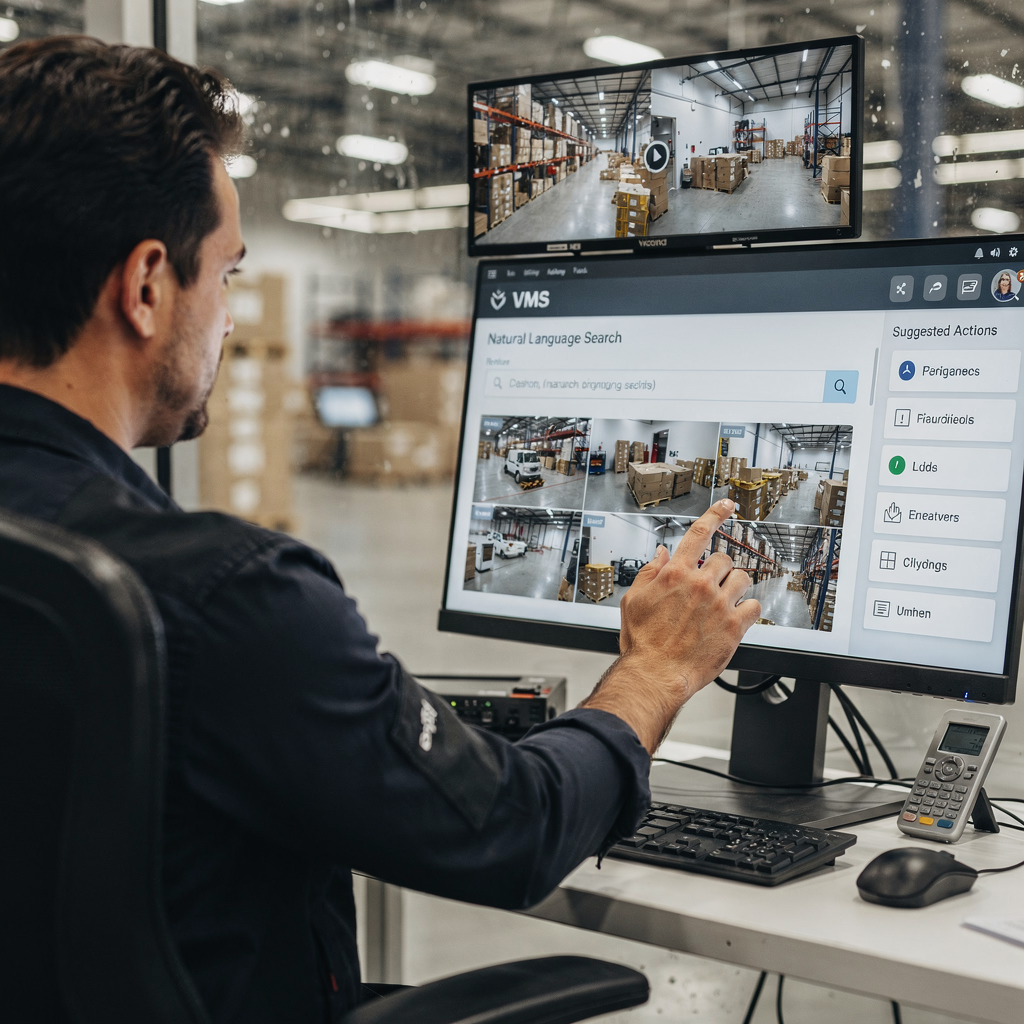

como funcionam os modelos visão-linguagem, casos de uso e aplicações de modelos visão-linguagem

Modelos visão-linguagem funcionam mapeando sinais visuais e consultas textuais em um espaço de representação compartilhado. Esse mapeamento possibilita tarefas de recuperação, classificação e explicação. Em VMS, operadores digitam comandos em linguagem natural como “mostrar filmagens de pessoas usando jaquetas vermelhas” e o sistema responde com clipes ranqueados. Essa busca semântica de vídeo reduz o tempo gasto navegando por filmagens. Para detecção de eventos, vlms podem gerar descrições em linguagem como “uma pessoa entrando em uma área restrita” ou “um veículo parando abruptamente”. Essas descrições em linguagem natural suportam marcação automatizada e sumarização. Um caso de uso concreto é vigilância de segurança. Nesse cenário, combinar feeds de câmera, logs de acesso e agentes de IA aumenta a consciência situacional. Um operador recebe um alerta explicado que correlaciona uma detecção com entradas de controle de acesso e contexto de câmera. visionplatform.ai demonstra isso com o VP Agent Reasoning, que verifica, explica e recomenda ações. Monitoramento de transporte é outro caso de uso onde vlms detectam quase-acidentes, monitoram fluxos de passageiros e suportam fluxos ANPR; veja nossa página de ANPR/LPR em aeroportos ANPR/LPR em aeroportos. Na saúde, vlms auxiliam no monitoramento de pacientes e detecção de quedas ao gerar descrições em linguagem natural de incidentes em tempo hábil; consulte nosso material sobre detecção de quedas em aeroportos Detecção de quedas em aeroportos para uma abordagem semelhante. Aplicações de modelos visão-linguagem incluem marcação automatizada, sumarização de vídeo, forense e visual question answering. Modelos podem gerar resumos de incidentes, pré-preencher relatórios e acionar fluxos de trabalho. Usar vlms também ajuda a controlar alarmes falsos fornecendo contexto e verificações cruzadas de outros sensores. Para tarefas forenses, a busca semântica possibilita consultas que correspondem à forma como humanos descrevem eventos, não apenas IDs de câmeras. De modo geral, vlms podem transformar VMS de arquivos passivos em sistemas pesquisáveis e explicáveis que apoiam decisões rápidas e consistentes.

avaliando modelos visão-linguagem e desenvolvendo modelos visão-linguagem: desempenho e tendências futuras

Avaliar modelos visão-linguagem requer uma mistura de métricas de acurácia, latência e robustez. A acurácia abrange precisão de detecção, qualidade de legendas e relevância de recuperação. Latência mede tempos de resposta de ponta a ponta para consultas ao vivo e verificação de alarmes em tempo real. Testes de robustez incluem desempenho sob variação de iluminação, oclusão e perturbações adversariais. KPIs operacionais também incluem redução do tempo do operador por alarme e taxas de falso positivo. Por exemplo, análises mostram que análises de vídeo com IA melhoraram a velocidade e a precisão da detecção de incidentes em pesquisas com usuários de VMS [fonte]. Persistem desafios. Carga computacional e viés de dados continuam sendo questões importantes. Restrições de privacidade e conformidade limitam o compartilhamento de dados e exigem abordagens on-prem ou edge para processamento. A anotação de dados é cara, por isso transfer learning e componentes pré-treinados de linguagem ou visão frequentemente formam a espinha dorsal de modelos de produção. Tendências emergentes focam em AI na edge, pipelines de baixa latência habilitados por 5G e técnicas de preservação de privacidade como aprendizado federado e inferência on-device. Desenvolver modelos visão-linguagem também significa melhorar explicabilidade e auditabilidade para que operadores confiem nas recomendações. Modelos mais novos enfatizam trilhas de auditoria, raciocínio determinístico e alinhamento com políticas como o AI Act da UE. Na prática, certifique-se de que vlms sejam testados em conjuntos de dados representativos e que monitoramento contínuo detecte drift. Sistemas futuros combinarão codificadores de visão e linguagem com agentes específicos do domínio para suportar fluxos de decisão. Em resumo, avaliar modelos visão-linguagem deve equilibrar métricas técnicas com fatores humanos. Equipes devem medir carga de trabalho do operador, velocidade de decisão e precisão na resolução de incidentes ao lado de F1 do modelo e tempo de inferência. À medida que vlms aprimoram VMS, eles desbloquearão novo valor operacional, exigindo governança e ferramentas cuidadosas.

FAQ

Qual é a diferença entre um modelo de linguagem e um modelo visão-linguagem?

Um modelo de linguagem processa texto e prevê palavras ou frases com base no contexto. Um modelo visão-linguagem combina entradas visuais com texto para que possa descrever imagens, responder a perguntas sobre vídeo e realizar busca semântica.

Como os vlms melhoram a busca forense em VMS?

VLMS indexam eventos visuais com descrições em linguagem natural, o que permite que operadores consultem filmagens usando termos do dia a dia. Isso reduz o tempo para encontrar incidentes e apoia investigações mais precisas.

VLMS podem rodar em dispositivos de edge ou precisam da nuvem?

VLMS podem rodar na edge, on-premise ou na nuvem dependendo das necessidades de desempenho e conformidade. Implantação na edge reduz latência e mantém o vídeo dentro do ambiente do cliente por motivos de privacidade.

Quais dados são necessários para treinar vlms para um local específico?

O treinamento requer vídeo anotado, legendas e transcrições representativas do local. Rótulos adicionais e fine-tuning ajudam o modelo a se adaptar a classes e comportamentos específicos do local.

Como codificadores de visão e codificadores de texto trabalham juntos?

O codificador de visão extrai características visuais dos frames, enquanto o codificador de texto converte palavras em vetores. Camadas de fusão ou cross-attention então alinham esses vetores para raciocínio conjunto e recuperação.

Existem riscos de privacidade ao implantar modelos visão-linguagem?

Sim. Vídeo e metadados podem ser sensíveis, portanto soluções on-premise e edge ajudam a reduzir exposição. Técnicas de preservação de privacidade e governança clara de dados são essenciais.

Quais métricas de desempenho devo acompanhar para vlms em VMS?

Acompanhe precisão de detecção, relevância de recuperação, latência de inferência, robustez sob condições variáveis e métricas operacionais como tempo economizado do operador. Essas métricas capturam tanto a qualidade do modelo quanto o impacto no negócio.

Como agentes de IA usam vlms dentro de uma sala de controle?

Agentes de IA consomem saídas de vlm, eventos do VMS e dados contextuais para verificar alarmes e recomendar ações. Agentes podem pré-preencher relatórios, sugerir respostas ou executar fluxos de trabalho dentro de permissões definidas.

VLMS podem reduzir alarmes falsos em vigilância?

Sim. Ao fornecer contexto, correlacionar múltiplas fontes e explicar detecções, vlms ajudam operadores a distinguir incidentes reais de ruído. Isso reduz falsos positivos e melhora o tempo de resposta.

Onde posso ver exemplos de aplicações de vlm em aeroportos?

visionplatform.ai documenta várias implantações práticas, como detecção de pessoas, ANPR/LPR, detecção de quedas e busca forense. Veja páginas como Detecção de pessoas em aeroportos, ANPR/LPR em aeroportos e Busca forense em aeroportos para exemplos reais.