Introdução ao Vision Transformer

O surgimento do Vision Transformer (ViT) marcou um momento crucial no campo da visão computacional (computer vision). Tradicionalmente dominado por redes neurais convolucionais (CNNs), a paisagem começou a mudar com a introdução do ViT, um modelo que aproveita a arquitetura de transformadores, originalmente projetada para o processamento de linguagem natural. Essa abordagem inovadora para classificação de imagens, como apresentada por Dosovitskiy et al., demonstra como um transformador puro aplicado diretamente a sequências de patches de imagem pode superar as CNNs estabelecidas em benchmarks importantes como o ImageNet, mesmo com recursos computacionais substancialmente menores.

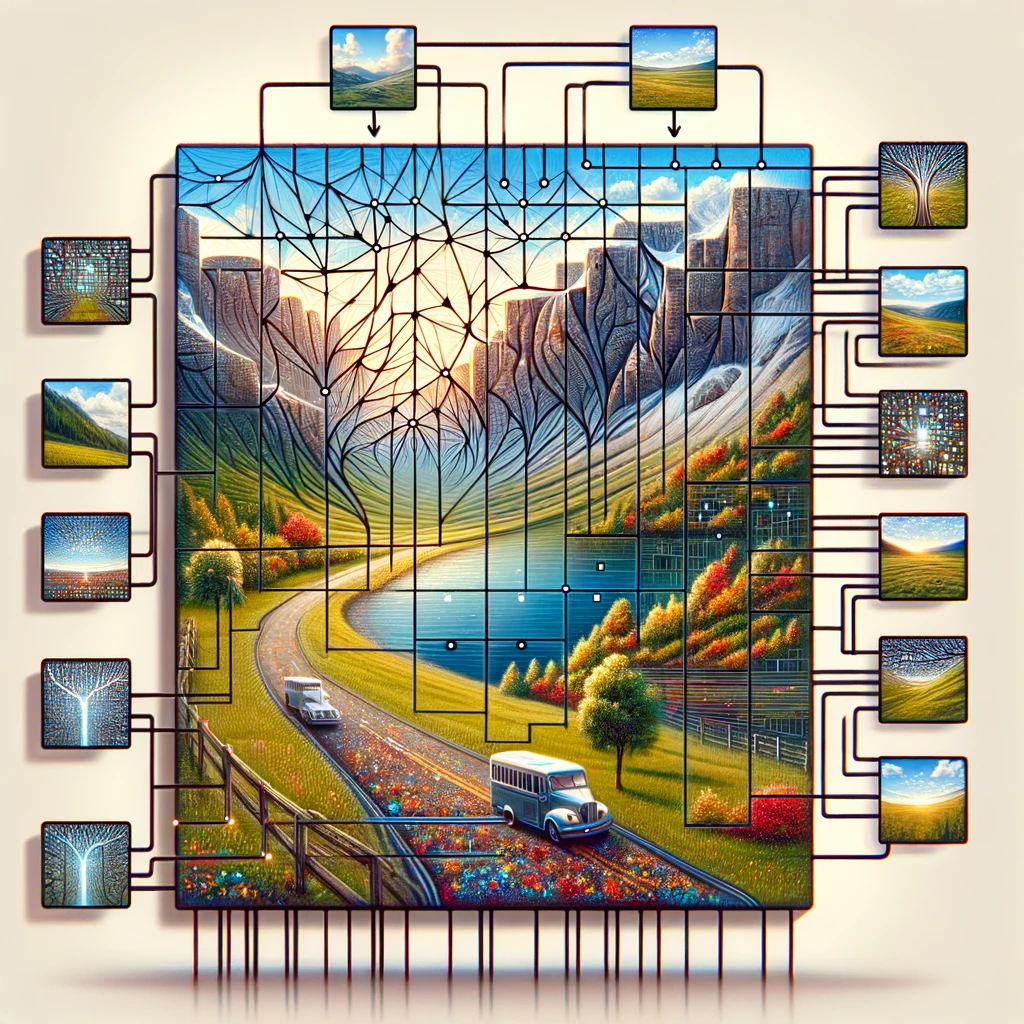

O Vision Transformer opera dividindo a imagem de entrada em uma grade de patches de imagem, tratando cada patch como um token semelhante a palavras em uma frase. Esses tokens são então incorporados junto com embeddings de posição para reter informações espaciais, um componente crucial para entender a imagem como um todo. O núcleo do modelo de transformador, o encoder de transformador padrão usa autoatenção para relacionar diferentes partes da imagem, permitindo que o modelo faça previsões com base em informações globais em vez de se concentrar em características locais como as CNNs fazem.

Essa mudança para o uso de transformadores para reconhecimento de imagens desafia a sabedoria convencional de que apenas camadas convolucionais podem processar dados visuais efetivamente. Ao demonstrar que um modelo de aprendizado profundo como o ViT se sai bem em tarefas de classificação de imagens com menos dados e menos intensidade computacional, ele abre caminho para soluções mais eficientes e escaláveis em reconhecimento de imagens em larga escala.

A Importância do ViT em Visão Computacional (computer vision)

O Vision Transformer (ViT) provocou uma renascença na visão computacional (computer vision) ao demonstrar que a arquitetura transformer não é apenas viável, mas altamente eficaz para tarefas de classificação de imagens. Diferentemente das abordagens tradicionais que dependem fortemente de redes neurais convolucionais (CNNs), o ViT trata uma imagem como uma sequência de patches, aplicando o transformer diretamente a essas sequências. Essa metodologia, inspirada pelo sucesso dos transformers no processamento de linguagem natural, provou funcionar excepcionalmente bem em tarefas de classificação de imagens, mostrando a versatilidade dos modelos de transformer em diferentes domínios da IA.

A introdução do modelo ViT por Dosovitskiy et al. destacou uma percepção crítica: “uma imagem vale 16×16 palavras“, equiparando metaforicamente cada patch de imagem de 16×16 pixels a uma palavra no processamento de texto. Essa analogia não foi apenas poética, mas também tecnicamente profunda, permitindo a aplicação de técnicas de pré-treinamento semelhantes às usadas em PLN. Tais modelos pré-treinados, quando ajustados para tarefas específicas de classificação de imagens, alcançam uma precisão notável, muitas vezes superando a das CNNs. A utilização de embeddings para converter valores de pixels de patches de imagens em vetores que podem ser processados por um codificador transformer exemplifica a capacidade do modelo de aprender padrões e relações complexas dentro dos dados visuais.

Além disso, o mecanismo de autoatenção dentro da arquitetura transformer permite que o ViT foque em partes relevantes da imagem, independentemente de sua posição espacial, facilitando um entendimento mais matizado do conteúdo visual. Essa abordagem não apenas aumenta a precisão do modelo em tarefas de classificação de imagens e segmentação de imagens, mas também reduz a dependência de grandes quantidades de dados tradicionalmente necessários para treinar modelos de aprendizado profundo em software de visão computacional (computer vision software).

Embeddings e Arquitetura Transformer: O Núcleo do ViT

Embeddings e arquitetura transformer formam a pedra angular do Vision Transformer (ViT), estabelecendo um novo padrão para como as imagens são analisadas e compreendidas em visão computacional (computer vision). Ao adotar o modelo transformer, uma tecnologia que revolucionou o processamento de linguagem natural, o ViT introduz uma mudança de paradigma no tratamento de dados visuais. O processo começa com a divisão da imagem de entrada em uma grade de patches de imagem, semelhante a cortar uma imagem em um mosaico de peças menores e gerenciáveis. Cada um desses patches de imagem, correspondendo a um token em processamento de linguagem natural (NLP), é então incorporado em um espaço vetorial de alta dimensão, capturando a essência das informações dos pixels de uma forma que está pronta para ser processada pela arquitetura transformer.

O gênio do ViT reside em sua capacidade de aplicar a arquitetura transformer diretamente a sequências desses patches de imagem embutidos. Esta abordagem diverge dos métodos convencionais de convolução ao aproveitar o poder da autoatenção, um mecanismo que permite ao modelo ponderar a importância de diferentes partes da imagem em relação umas às outras. Ao fazer isso, o ViT captura tanto o contexto local quanto o global, possibilitando um entendimento matizado dos dados visuais que vai além do que as redes neurais convolucionais (CNNs) podem alcançar.

Além disso, a adição de embeddings de posição é crucial, pois confere à sequência de patches informações espaciais, permitindo que o modelo transformer entenda o arranjo e a relação entre diferentes partes da imagem. Este método, pioneiro por Dosovitskiy et al., mostra como um transformer puro aplicado diretamente a sequências de patches de imagem pode se destacar em tarefas de visão computacional (computer vision), como classificação de imagens e segmentação de imagens, com menos recursos computacionais e menos dependência de vastos conjuntos de dados. A arquitetura ViT, portanto, não apenas se destaca como um testemunho da escalabilidade e eficiência dos transformers, mas também anuncia uma nova era de inovação em plataformas de visão computacional (computer vision platforms), prometendo avanços na forma como as máquinas percebem e interpretam o mundo visual.

O Papel da Autoatenção no Vision Transformer

O modelo Vision Transformer revoluciona as tarefas de visão computacional (computer vision) através do seu uso inovador da autoatenção, um princípio central emprestado da arquitetura original do transformer. Esse mecanismo permite que o modelo foque em diferentes partes de uma imagem inteira, determinando a importância de cada área com base na tarefa de classificação de imagens. Ao analisar a imagem dividida em patches, o Vision Transformer pode apresentar um desempenho muito bom no reconhecimento de imagens, mesmo com vários conjuntos de dados de imagens de tamanho médio ou pequeno. A cabeça de classificação da arquitetura do modelo traduz as relações complexas descobertas entre os patches em rótulos de classe para a imagem, demonstrando um entendimento profundo do conteúdo e localização na imagem original.

Essa abordagem contrasta fortemente com as redes convolucionais tradicionais, mantendo o foco na eficiência computacional. Pesquisas indicam que tal modelo, pré-treinado em grandes quantidades de dados e transferido para vários benchmarks de reconhecimento de imagens de tamanho médio ou pequeno, alcança excelentes resultados em comparação com as redes convolucionais de última geração. Ele mostra efetivamente que a dependência das CNNs não é necessária para muitas tarefas de visão computacional (computer vision). O bloco transformer dentro do Vision Transformer, particularmente o transformer com atenção multi-cabeça, permite que o modelo processe esses patches em paralelo, oferecendo insights sobre a imagem como um todo, em vez de partes isoladas. Este método sublinha o potencial transformador do uso de transformers em tarefas de processamento de visão, onde todo o panorama de aplicações para visão computacional (computer vision) permanece em grande parte inexplorado, mas promissor.

Vision Transformer vs. Redes Neurais Convolucionais

O modelo Vision Transformer apresenta uma mudança revolucionária na forma como as tarefas de visão computacional (computer vision) são abordadas, desafiando a longa dominação das CNNs. O artigo intitulado “Uma Imagem Vale 16×16 Palavras” encapsula a essência da metodologia do Vision Transformer, tratando a imagem inteira como uma série de blocos transformadores para processar. Este design transformador original, adaptado para visão, depende da segmentação de uma imagem em patches que podem se sair muito bem em diferentes tarefas de reconhecimento de imagens, incorporando a frase “uma imagem vale 16*16 palavras”.

Em comparação, as CNNs tradicionalmente analisam imagens através de filtros convolucionais, focando em características locais dentro de pequenos campos receptivos. No entanto, os Vision Transformers não possuem essas restrições, utilizando a autoatenção para avaliar globalmente as relações entre os patches, independentemente de sua localização na imagem original. Essa diferença fundamental permite que os Vision Transformers capturem mais informações contextuais, provando que para muitas tarefas de visão computacional (computer vision), a arquitetura de modelo puramente transformador não apenas compete, mas muitas vezes supera os modelos convolucionais atuais.

Além disso, o artigo de pesquisa demonstra que os modelos Vision Transformer, especialmente quando pré-treinados em grandes conjuntos de dados, podem ser transferidos efetivamente para uma variedade de tarefas de visão computacional (computer vision). Essa adaptabilidade destaca sua versatilidade e potencial para redefinir a paisagem do processamento de visão, oferecendo uma alternativa convincente ao paradigma convolucional. Os modelos ViT superam os benchmarks atuais, desafiando a necessidade de abordagens convolucionais e abrindo caminho para uma nova era na visão computacional (computer vision).

| Modelo | Parâmetros (Milhões) | Tamanho da Imagem | Precisão Top-1 (ImageNet) | Conjuntos de Dados Usados para Pré-treinamento | Características Especiais |

|---|---|---|---|---|---|

| ViT-Base | 86 | 384×384 | 77.9% | ImageNet | Modelo ViT original |

| ViT-Large | 307 | 384×384 | 76.5% | ImageNet | Versão maior do ViT-Base |

| ViT-Huge | 632 | 384×384 | 77.0% | ImageNet | Maior modelo ViT |

| DeiT-Small | 22 | 224×224 | 79.8% | ImageNet | Token de destilação para eficiência no treinamento |

| DeiT-Base | 86 | 224×224 | 81.8% | ImageNet | Versão maior do DeiT-Small |

| Swin Transformer | 88 | 224×224 | 83.0% | ImageNet-21k, ImageNet | Arquitetura hierárquica, eficiência aprimorada |

A Perspectiva do Inovador: Dosovitskiy e a Revolução das Redes Neurais

O impacto transformador do Vision Transformer (ViT) em tarefas de visão computacional (computer vision) deve muito ao trabalho pioneiro detalhado no artigo de pesquisa da conferência intitulado “An Image is Worth 16×16 Words” por Dosovitskiy et al. Este artigo seminal não apenas introduziu uma nova arquitetura de modelo, mas também mudou o paradigma do processamento de imagens de redes convolucionais para um framework onde transformadores trabalham diretamente com sequências de patches de imagens. O modelo de transformador de visão, introduzido por esta pesquisa, emprega uma série de blocos transformadores para analisar a imagem inteira, quebrando-a em patches que, surpreendentemente, podem apresentar um desempenho muito bom em vários benchmarks de reconhecimento de imagens.

O trabalho de Dosovitskiy desafia a dependência convencional em CNNs para tarefas de visão, demonstrando que um modelo pré-treinado em vastas quantidades de dados e transferido para diferentes tarefas de reconhecimento de imagens não só alcança excelentes resultados em comparação com as redes convolucionais de última geração, mas, em muitos casos, os supera significativamente. Essa evidência sugere que as aplicações em visão computacional (computer vision), há muito consideradas limitadas sem redes convolucionais, são de fato expansivas quando se empregam transformadores. O sucesso do ViT reside em sua capacidade de considerar a imagem em sua totalidade, aproveitando os embeddings de posição e a autoatenção para entender a relação entre os patches, independentemente de sua localização na imagem original.

Além disso, os insights do artigo sobre a eficiência do modelo sublinham uma vantagem crucial: os Vision Transformers requerem substancialmente menos recursos computacionais do que seus equivalentes CNN enquanto entregam um desempenho superior. Essa eficiência, combinada com a escalabilidade do modelo em muitas tarefas de visão computacional (computer vision), desde classificação de imagens até segmentação, anuncia uma nova direção no design e aplicação de redes neurais. Como o ViT mostra, e variantes subsequentes do ViT como o Swin Transformer comprovam ainda mais, o futuro da visão computacional (computer vision) reside na arquitetura transformadora versátil e poderosa, um caminho primeiro iluminado por Dosovitskiy e sua equipe.

Unindo Visão e Linguagem: Do Processamento de Linguagem Natural ao Vision Transformer

O surgimento do modelo Vision Transformer (ViT) no âmbito das tarefas de visão computacional (computer vision) marca um avanço significativo, unindo metodologias do processamento de linguagem natural (NLP) à compreensão visual. Esse salto inovador foi documentado no artigo de pesquisa intitulado “Uma Imagem Vale 16×16 Palavras”, que esclarece como o ViT emprega uma série de blocos transformadores, um conceito emprestado da arquitetura do modelo transformador original usado em NLP. O cerne dessa adaptação reside em tratar a imagem inteira como uma sequência de pontos de dados, de forma semelhante a como as frases são vistas como sequências de palavras em NLP.

Essa metodologia destaca a capacidade única do transformador de processar e analisar dados visuais. Ao contrário das redes convolucionais tradicionais, que exigem operações de filtragem local e pooling, os modelos ViT aproveitam mecanismos de autoatenção que permitem ao modelo considerar a imagem inteira, facilitando uma compreensão abrangente do contexto local e global. O transformador com atenção multi-cabeça enriquece ainda mais esse processo, permitindo que o modelo foque em várias partes da imagem simultaneamente, aprimorando sua capacidade de discernir padrões e relações intrincados nos dados visuais.

Além disso, a cabeça de classificação do ViT, crucial para atribuir rótulos de classe à imagem, significa uma ruptura com o paradigma convolucional, ilustrando que a dependência de CNNs não é necessária para alcançar excelência em visão computacional (computer vision). Por meio do uso eficaz de transformadores, o ViT alcança resultados excelentes em comparação com redes convolucionais de última geração em um espectro de tarefas de visão computacional (computer vision), reforçando o argumento de que as aplicações em visão computacional (computer vision) vão muito além dos limites convencionais estabelecidos por modelos anteriores.

Mergulho Profundo na Arquitetura ViT

A arquitetura do modelo Vision Transformer representa uma mudança de paradigma na forma como as imagens são interpretadas para tarefas de visão computacional (computer vision). Central para essa arquitetura do modelo é o uso inovador de patches de imagem, semelhantes a tokens no processamento de linguagem natural, que são processados através de um bloco transformador. Essa abordagem se desvia dos métodos tradicionais ao permitir que a imagem inteira seja analisada de maneira holística, em vez de através da lente localizada das operações convolucionais.

Cada imagem é dividida em patches de tamanho fixo, que podem se sair muito bem por conta própria em vários benchmarks de reconhecimento de imagens pequenas. Esses patches, uma vez incorporados junto com embeddings de posição para manter sua localização na imagem original, são alimentados no modelo transformador. Aqui, a magia da arquitetura transformadora se desdobra, utilizando mecanismos de autoatenção para pesar dinamicamente a importância de cada patch em relação aos outros, criando assim uma compreensão matizada do conteúdo visual.

Essa arquitetura, introduzida pela primeira vez no artigo fundamental intitulado “An Image is Worth 16*16 Words”, sublinha a eficiência do modelo. Ao aproveitar o trabalho dos transformadores, originalmente projetados para texto, os modelos ViT superam os benchmarks atuais estabelecidos por redes convolucionais. Além disso, o ViT emprega uma cabeça de classificação que traduz a compreensão abstrata da imagem em rótulos de classe concretos, demonstrando a proeza do modelo em navegar pela tarefa de classificação de imagens com notável precisão.

Explorando Variantes do ViT e Seu Impacto

Desde a introdução do modelo original do Vision Transformer, a exploração de variantes do ViT tem sido uma área vibrante de pesquisa, expandindo os limites do que é possível em tarefas de visão computacional (computer vision). Essas variantes, projetadas para lidar com uma ampla gama de tarefas de processamento de visão, sublinham a versatilidade e adaptabilidade da arquitetura do transformer ao abordar as complexidades dos dados visuais.

Um dos avanços mais notáveis neste domínio é o desenvolvimento do Swin Transformer, um modelo que utiliza uma arquitetura de transformer hierárquica otimizada para eficiência e escalabilidade. Diferentemente dos modelos ViT maiores que processam a imagem inteira de maneira uniforme, o Swin Transformer introduz uma abordagem inovadora para a partição da imagem em patches, que então passam por uma série de camadas de transformer com atenção multi-cabeça. Este método permite uma adaptação mais dinâmica e flexível às escalas variadas de características visuais presentes em uma imagem, desde os detalhes minuciosos até a estrutura abrangente.

O impacto dessas variantes do ViT é profundo, demonstrando que os transformers, apesar de originalmente concebidos para PLN, possuem um potencial imenso em revolucionar a visão computacional (computer vision). Ao empregar diferentes ajustes arquitetônicos e otimizações, como os vistos nas variantes do ViT, os pesquisadores mostraram que esses modelos podem desempenhar muito bem no reconhecimento de imagens em escala, incluindo em vários benchmarks de imagens de tamanho médio ou pequeno. O sucesso dessas variantes não apenas atesta a flexibilidade inerente do modelo de transformer em se adaptar a diferentes tarefas, mas também destaca o potencial para futuras inovações no campo, prometendo mais melhorias em precisão, eficiência e aplicabilidade em um espectro mais amplo de desafios de visão computacional (computer vision).

Como os Transformadores Funcionam em Visão: Um Olhar Mais Atento ao ViT

A arquitetura do modelo Vision Transformer (ViT), introduzida no artigo de pesquisa da conferência intitulado “Uma Imagem Vale 16*16 Palavras”, apresenta uma abordagem revolucionária na qual o uso de transformadores para tarefas de visão computacional (visão computacional) não é apenas viável, mas altamente eficaz. Esta arquitetura de modelo sublinha que uma abordagem de transformador necessária e pura, desprovida de redes convolucionais enquanto mantém a eficiência computacional em cheque, pode oferecer insights profundos sobre a imagem inteira. Através da divisão de uma imagem em patches, o ViT demonstra que esses patches de imagem podem ter um desempenho excepcionalmente bom em várias tarefas de reconhecimento de imagens.

O ViT emprega uma série de blocos transformadores que processam os dados visuais. Este método permite que o modelo considere a imagem inteira de forma holística, um desvio significativo da análise localizada típica das redes neurais convolucionais (CNNs). O artigo intitulado “Uma Imagem Vale 16*16 Palavras” muda fundamentalmente o paradigma, mostrando que essa dependência das CNNs não é necessária para alcançar alto desempenho em muitas tarefas de visão computacional (visão computacional). Ao tratar cada patch como um token, semelhante a como as palavras são tratadas no processamento de linguagem natural, o ViT aproveita o mecanismo de autoatenção do transformador original, permitindo que ele foque dinamicamente em diferentes partes da imagem e como elas se relacionam entre si.

Além disso, a capacidade do modelo de ser pré-treinado em grandes quantidades de dados e depois transferido para vários benchmarks de reconhecimento de imagens de tamanho médio ou pequeno atesta sua versatilidade e eficácia. Essa adaptabilidade sublinha o potencial do transformador em tarefas de visão, onde ele alcança resultados excelentes em comparação com as redes convolucionais de última geração, redefinindo assim os limites do que é possível em visão computacional (visão computacional).

Explorando Variantes do ViT e Seu Impacto

A evolução dos modelos Vision Transformer (ViT) levou ao desenvolvimento de várias variantes do ViT, cada uma adaptada para tarefas específicas de visão computacional (computer vision), incluindo benchmarks de reconhecimento de imagens de tamanho médio ou pequeno. Essas variantes ilustram o poder transformador de adaptar a arquitetura do modelo para atender a diferentes requisitos, mostrando que as aplicações em visão computacional (computer vision) permanecem vastas e longe de serem limitadas. Entre elas, os modelos ViT maiores e aqueles especializados para benchmarks de reconhecimento de imagens pequenas têm avançado significativamente, demonstrando que os patches podem ter um desempenho muito bom em uma variedade diversa de tarefas visuais.

Uma variante notável, o Swin Transformer, exemplifica as modificações engenhosas ao modelo ViT padrão que usa uma abordagem hierárquica para processar a imagem. Essa arquitetura de modelo permite um manuseio mais eficiente da imagem inteira, ajustando-se dinamicamente à escala e complexidade do conteúdo. Tais inovações destacam a importância de usar transformadores em tarefas de visão, onde eles podem aproveitar as capacidades inerentes do modelo para análises tanto amplas quanto detalhadas.

Além disso, o sucesso dessas variantes, particularmente na forma como são pré-treinadas em grandes quantidades de dados e transferidas para enfrentar diferentes desafios de reconhecimento de imagens, sublinha a flexibilidade e o potencial dos modelos baseados em transformadores em visão computacional (computer vision). A capacidade das variantes do ViT de superar consistentemente os benchmarks atuais estabelecidos por redes convolucionais tradicionais sinaliza uma mudança para uma abordagem mais versátil e poderosa para tarefas de visão computacional (computer vision), abrindo caminho para futuros avanços no campo.

Usando Transformadores Além do Texto: Transformador de Visão em Ação

O modelo Transformador de Visão (ViT), desde sua introdução em 2021, demonstrou a versatilidade dos transformadores além de sua aplicação original no processamento de linguagem natural. Essa expansão para tarefas de visão computacional (computer vision) foi recebida com considerável sucesso, como evidenciado pela capacidade dos modelos ViT de superar as redes convolucionais de última geração em uma variedade de benchmarks. A arquitetura do modelo, que decompõe a imagem inteira em patches, ilustra que um transformador com atenção multi-cabeça pode processar efetivamente dados visuais, desafiando a crença de longa data de que as CNNs são necessárias para essas tarefas.

As aplicações do ViT em visão computacional (computer vision) demonstraram sua eficácia não apenas em áreas tradicionais como reconhecimento de imagens, mas também em tarefas mais matizadas que requerem um entendimento da interação complexa entre diferentes partes dos dados visuais. Essa capacidade deriva do design do modelo, que, conforme descrito no artigo intitulado “Uma Imagem Vale 16*16 Palavras”, permite uma análise detalhada e abrangente da imagem, aproveitando tanto as informações individuais quanto coletivas dos patches.

O sucesso do ViT em várias tarefas de visão computacional (computer vision) demonstra o potencial dos modelos transformadores para redefinir a paisagem do processamento visual. Enquanto o ViT mostra que os transformadores não têm as limitações frequentemente associadas às CNNs, ele emprega uma abordagem única para entender os dados visuais que combina a profundidade e a nuance da visão humana com a escalabilidade e eficiência dos modelos de aprendizado de máquina. Esse uso inovador de transformadores em tarefas de visão anuncia uma nova era na visão computacional (computer vision), onde as aplicações e implementações em dispositivos Edge, como o NVIDIA Jetson (https://visionplatform.ai/what-is-edge-computing-for-computer-vision-and-what-are-the-benefits/), desses modelos estão apenas começando a ser exploradas.

Swin Transformer: Uma Nova Variante do ViT

O Swin Transformer representa um avanço significativo na paisagem das variantes do Vision Transformer (ViT), introduzindo uma abordagem inovadora que adapta o modelo de transformer para um desempenho aprimorado em um espectro de tarefas de visão computacional (visão computacional). Como um modelo que utiliza uma arquitetura de transformer hierárquica, o Swin Transformer redefine o processamento da imagem inteira, segmentando-a em patches que são escalados dinamicamente, permitindo uma análise mais granular e eficiente.

Essa inovação arquitetônica é particularmente hábil em lidar com várias escalas de dados visuais, tornando-se adequada para tarefas que vão desde o reconhecimento detalhado de imagens até o entendimento abrangente de cenas. O design do Swin Transformer enfatiza a flexibilidade e a escalabilidade, permitindo que ele gerencie eficientemente as demandas computacionais associadas ao processamento de imagens grandes. Ao empregar um mecanismo de atenção menor e mais focado dentro de cada bloco de transformer, o Swin Transformer garante que os recursos computacionais necessários sejam precisamente alocados, melhorando a eficiência geral do modelo.

O impacto do Swin Transformer vai além de apenas melhorias técnicas; ele sinaliza uma mudança mais ampla na forma como os transformers são aplicados à visão computacional (visão computacional), destacando o potencial para esses modelos evoluírem e se adaptarem em resposta às demandas diversas e crescentes do campo. Como uma nova variante do ViT, o Swin Transformer estabelece um novo padrão para o que é possível com modelos baseados em transformer em visão computacional (visão computacional), prometendo mais inovações e aplicações que poderiam redefinir os limites da análise e interpretação de imagens.

Conclusão: O Futuro da Visão Computacional com o Vision Transformer

A introdução e evolução do Vision Transformer (ViT) inauguraram uma nova era para a visão computacional (computer vision), desafiando metodologias convencionais e estabelecendo uma direção promissora para pesquisas e aplicações futuras. O impacto transformador dos modelos ViT, sublinhado pela sua capacidade de superar redes convolucionais de última geração em diversos benchmarks, destaca o imenso potencial da tecnologia de transformadores em redefinir a paisagem das tarefas de visão computacional (computer vision).

O sucesso do ViT e suas variantes, como o Swin Transformer, demonstra a adaptabilidade e eficácia dos modelos de transformadores em abordar uma ampla gama de desafios de processamento visual. Ao aproveitar os princípios de autoatenção e compreensão de contexto global, os modelos ViT mostraram que uma análise abrangente e matizada dos dados visuais é alcançável, superando as capacidades das abordagens convolucionais tradicionais.

Olhando para o futuro, a exploração e desenvolvimento contínuos dos modelos ViT prometem desbloquear capacidades ainda maiores em visão computacional (computer vision). O potencial desses modelos para aprimorar e expandir o escopo de aplicações no campo é vasto, variando desde sistemas avançados de reconhecimento de imagens até ferramentas sofisticadas de análise de cenas. À medida que pesquisadores e profissionais constroem sobre o trabalho fundamental do ViT, o futuro da visão computacional (computer vision) parece preparado para uma onda de inovações que irão aproveitar ainda mais o poder dos transformadores, impulsionando as capacidades das máquinas para entender e interpretar o mundo visual com visão de máquina com profundidade e precisão sem precedentes.

Perguntas Frequentes sobre Transformadores de Visão

Os Transformadores de Visão (ViTs) surgiram como uma tecnologia revolucionária no campo da visão computacional (visão computacional), desafiando abordagens convencionais e oferecendo novas possibilidades. À medida que o interesse nos ViTs cresce, também crescem as perguntas sobre sua funcionalidade, vantagens e aplicações. Abaixo, compilamos uma lista de perguntas frequentes para fornecer insights sobre o impacto transformador dos Transformadores de Visão no processamento e análise de imagens.

O que são Transformadores de Visão?

Os Transformadores de Visão (ViTs) são uma classe de modelos de aprendizado profundo adaptados dos transformadores em processamento de linguagem natural (NLP) para lidar com tarefas de visão computacional (visão computacional). Ao contrário dos métodos tradicionais que dependem de redes neurais convolucionais (CNNs), os ViTs dividem imagens em patches e aplicam mecanismos de autoatenção para capturar dependências globais dentro da imagem. Essa abordagem permite que os ViTs alcancem desempenho superior em várias tarefas de processamento de imagens, incluindo, mas não se limitando a, classificação de imagens, detecção de objetos e segmentação semântica.

Como funcionam os Transformadores de Visão?

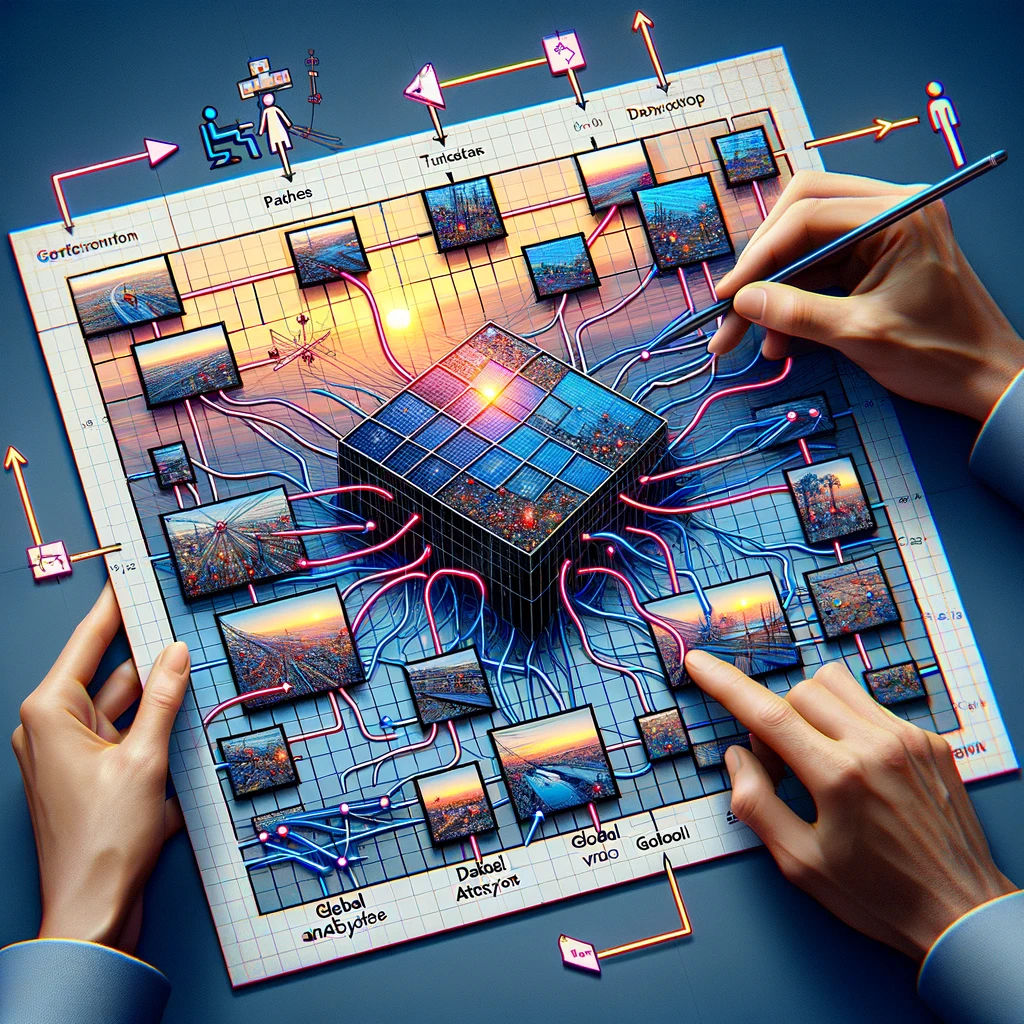

Os Transformadores de Visão funcionam dividindo inicialmente uma imagem em uma grade de patches de tamanho fixo. Cada patch é então achatado e transformado em um vetor por meio de um processo chamado de incorporação. Esses vetores, juntamente com codificações posicionais, são alimentados em uma série de blocos transformadores que utilizam mecanismos de autoatenção para entender as relações entre diferentes patches da imagem. Esse processo permite que o modelo considere todo o contexto da imagem, melhorando sua capacidade de classificar ou interpretar dados visuais com precisão.

Por que os Transformadores de Visão são importantes para tarefas de visão computacional?

Os Transformadores de Visão são importantes para tarefas de visão computacional (visão computacional) porque introduzem uma nova abordagem para análise de imagens que se afasta da perspectiva local das CNNs. Ao aproveitar mecanismos de autoatenção, os ViTs podem considerar a imagem inteira de forma holística, levando a um desempenho melhorado em tarefas como classificação de imagens, onde demonstraram superar as CNNs em benchmarks como o ImageNet com taxas de precisão superiores a 88%. Sua capacidade de processar eficientemente características globais de imagens os torna uma ferramenta poderosa no avanço da visão computacional.

Os Transformadores de Visão podem superar as CNNs em Reconhecimento de Imagens?

Sim, os Transformadores de Visão podem superar as CNNs em tarefas de reconhecimento de imagens. Estudos mostraram que os ViTs alcançam desempenho de ponta em benchmarks importantes, incluindo o ImageNet, onde alcançaram níveis de precisão que superam os modelos de CNN avançados. A chave para o sucesso deles reside na capacidade do transformador de capturar dependências de longo alcance em toda a imagem, permitindo uma compreensão e classificação mais abrangentes dos dados visuais.

O que torna os Transformadores de Visão eficientes em Classificação de Imagens?

Os Transformadores de Visão são eficientes em classificação de imagens devido à sua capacidade de aprender características globais de imagens através de mecanismos de autoatenção. Ao contrário das CNNs, que se concentram principalmente em características locais, os ViTs analisam as relações entre todas as partes de uma imagem, permitindo que capturem padrões complexos de forma mais eficaz. Além disso, a escalabilidade dos modelos transformadores permite um treinamento eficiente em grandes conjuntos de dados, melhorando ainda mais seu desempenho em tarefas de classificação de imagens com resultados cada vez mais precisos à medida que o tamanho do conjunto de dados aumenta.

Como os Transformadores de Visão são treinados?

Os Transformadores de Visão são tipicamente treinados usando grandes conjuntos de dados, muitas vezes aproveitando uma técnica conhecida como aprendizado por transferência. Inicialmente, um modelo ViT é pré-treinado em um vasto conjunto de dados, como o ImageNet, que contém milhões de imagens em milhares de categorias. Esse processo de pré-treinamento permite que o modelo aprenda uma grande variedade de características visuais. Posteriormente, o modelo pode ser ajustado em conjuntos de dados menores e específicos para tarefas para alcançar alto desempenho em tarefas específicas de visão computacional (visão computacional), reduzindo significativamente o tempo de treinamento e os recursos computacionais necessários.

Quais são as aplicações dos Transformadores de Visão?

Os Transformadores de Visão têm sido aplicados com sucesso em uma variedade de tarefas de visão computacional (visão computacional), desde classificação básica de imagens até desafios complexos como detecção de objetos, segmentação semântica e geração de imagens. Por exemplo, em classificação de imagens, os ViTs alcançaram taxas de precisão superiores a 88% no benchmark ImageNet. Sua capacidade de entender o contexto global das imagens também os torna ideais para análise de imagens médicas, navegação de veículos autônomos e sistemas de recuperação de imagens baseados em conteúdo, mostrando sua versatilidade em vários domínios.

Quais são os desafios da implementação de Transformadores de Visão?

A implementação de Transformadores de Visão vem com desafios, principalmente devido à sua complexidade computacional e à necessidade de grandes quantidades de dados de treinamento. Os ViTs requerem recursos significativos de GPU para treinamento, o que pode ser uma barreira para aqueles sem acesso a instalações de computação de alto desempenho. Além disso, embora eles se destaquem com grandes conjuntos de dados, seu desempenho em conjuntos de dados menores sem pré-treinamento extensivo pode ficar atrás do de modelos mais tradicionais, como as CNNs. Otimizar os ViTs para tarefas específicas e gerenciar os requisitos de recursos são desafios chave para uma adoção mais ampla.

Como os Transformadores de Visão lidam com Imagens Grandes?

Os Transformadores de Visão lidam com imagens grandes dividindo-as em patches menores e gerenciáveis que são processados independentemente, permitindo que o modelo escale sua análise de acordo com o tamanho da imagem. Essa abordagem baseada em patches permite que os ViTs mantenham alto desempenho mesmo à medida que as resoluções das imagens aumentam, sem um aumento proporcional no custo computacional. Para imagens extremamente grandes, técnicas como processamento hierárquico podem ser empregadas, onde a arquitetura do modelo é adaptada para analisar imagens em várias resoluções, aumentando ainda mais sua eficiência e precisão.

Qual é o futuro dos Transformadores de Visão na Visão Computacional?

O futuro dos Transformadores de Visão na visão computacional (visão computacional) parece promissor, com pesquisas em andamento visando aprimorar sua eficiência, precisão e aplicabilidade a uma gama mais ampla de tarefas. Esforços para reduzir seus requisitos computacionais, melhorar métodos de treinamento e desenvolver modelos mais robustos para pequenos conjuntos de dados são áreas chave de foco. Além disso, à medida que os ViTs continuam a superar modelos tradicionais em vários benchmarks, espera-se que sua integração em aplicações do mundo real, desde diagnósticos de saúde até sistemas automatizados em veículos e smartphones, cresça, consolidando ainda mais seu papel no avanço da tecnologia de visão computacional.