Visão geral da navegação temporal na compreensão de vídeo

A compreensão de vídeo está na interseção entre percepção e contexto. Ela se apoia em visão computacional e linguagem para interpretar cenas em movimento. Em contextos dinâmicos, os sistemas devem não apenas detectar objetos, mas também acompanhar como esses objetos mudam e interagem ao longo do tempo. Navegação temporal, nesse cenário, significa rastrear eventos, ordená-los e ligar causas a efeitos à medida que a sequência se desenrola. Isso difere da análise de imagem estática porque um único quadro não pode mostrar um início ou um desfecho. Em vez disso, os sistemas precisam processar sequências de quadros e manter estado. Essa necessidade valoriza pipelines eficientes e estruturas claras para inferência contínua.

A compreensão temporal requer um conjunto de capacidades. Primeiro, os sistemas devem extrair características por quadro com rapidez. Em seguida, devem mapear essas características em uma representação estruturada para interpretação semântica de nível superior. Finalmente, devem usar essa estrutura para responder perguntas, tomar decisões ou acionar ações. Para cenários operacionais, precisamos construir modelos que possam operar em feeds ao vivo com latência limitada. Por exemplo, salas de controle frequentemente precisam verificar alarmes e fornecer aos operadores contexto em segundos. visionplatform.ai baseia-se nessa ideia convertendo feeds de câmeras em descrições legíveis por humanos e permitindo que agentes de IA raciocinem sobre esse fluxo para propor ações quando necessário. Essa abordagem ajuda a reduzir o tempo por alarme e atende a restrições de privacidade on-prem.

Para fundamentar a discussão, considere o conjunto de dados SOK-Bench. Ele ajuda a avaliar quão bem os modelos lidam com conhecimento situado e vínculos temporais entre clipes, e fornece aos pesquisadores um benchmark claro para comparar métodos artigo SOK-Bench. Além disso, levantamentos sobre legendagem densa de vídeo mostram como coleções anotadas maiores possibilitam treinamentos mais ricos e avaliações melhores para sequenciamento de eventos levantamento sobre legendagem densa de vídeo. Por fim, abordagens em streaming demonstram como grandes modelos de linguagem podem raciocinar à medida que lêem dados que chegam StreamingThinker. Juntos, esses trabalhos esboçam uma visão geral da navegação temporal na compreensão de vídeo. Eles destacam a necessidade de unificar percepção de curto prazo e inferência de longo prazo em streams de vídeo ao vivo.

Taxonomia de tarefas para raciocínio em vídeo

O raciocínio em vídeo organiza-se em uma taxonomia clara de tarefas. No nível mais baixo, a detecção por quadro identifica entidades como pessoas, veículos ou objetos. Esses detectores formam a entrada para módulos de reconhecimento de atividade que identificam ações em clipes curtos. Em seguida, o sequenciamento de eventos reúne essas ações em instâncias de nível superior, como “aproxima, perambula, depois parte”. Em um nível mais alto, tarefas de raciocínio hierárquico formam inferências em nível de cena e cadeias causais. Essas tarefas exigem raciocínio relacional e compreensão das dependências temporais entre tomadas e ângulos de câmera.

Podemos dividir as tarefas centrais em categorias. Tarefas de percepção incluem detecção de pessoas e veículos, ANPR/LPR e verificações de EPI. Para contextos de vigilância e aeroportos, a visionplatform.ai usa detectores que operam on-prem e streamam eventos estruturados para um pipeline de agentes. Para fluxos de trabalho forenses, a plataforma suporta busca em linguagem natural sobre linhas do tempo gravadas, o que complementa ferramentas clássicas de busca forense busca forense. As tarefas de decisão então combinam detecções com contexto. Por exemplo, um detector de intrusão sinaliza um evento. Em seguida, um módulo de raciocínio verifica logs de acesso, câmeras próximas e atividade recente para validar o alerta. Isso integra video-llms e lógica de agentes para reduzir falsos positivos detecção de intrusões.

Tarefas de nível mais alto incluem question answering em vídeo e avaliação de cenários em múltiplas interações. Essas tarefas exigem vincular entidades a trajetórias ao longo de sequências estendidas. Também exigem modelos espaço-temporais que possam representar grafos de entidades e suas interações. Para implantações reais, pedimos que os modelos realizem sumários de cena, gerem relatórios de incidentes legíveis por humanos e recomendem ações. Por exemplo, o VP Agent pode preencher previamente formulários de incidente com base em detecções estruturadas, o que acelera a resposta dos operadores. A taxonomia, portanto, abrange desde extração de quadros até montagem de cadeias causais e suporte à decisão. Essa estrutura ajuda pesquisadores e profissionais a escolherem o conjunto de dados e o método de avaliação apropriados para cada tarefa.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Avaliação por benchmark para compreensão de vídeo

Os benchmarks orientam o progresso ao fornecer conjuntos de dados, métricas e baselines padronizados. O SOK-Bench se destaca por alinhar clipes de vídeo situados com conhecimento de mundo aberto e tarefas de raciocínio. O conjunto contém clipes com anotações que exigem vincular evidências visuais a conhecimento externo. O artigo do SOK-Bench descreve claramente sua estrutura e objetivos de avaliação SOK-Bench. Pesquisadores o utilizam para avaliar se os modelos conseguem fundamentar respostas em eventos observados e fatos alinhados.

A avaliação cobre tanto precisão quanto fidelidade temporal. Resultados recentes relatam melhorias de precisão de aproximadamente 15–20% no SOK-Bench em comparação com baselines anteriores, o que indica raciocínio temporal e alinhamento de conhecimento mais fortes resultados do SOK-Bench. A latência também é uma métrica chave. O StreamingThinker mostra cerca de 30% de redução na latência de processamento quando os modelos raciocinam incrementalmente em vez de em lotes StreamingThinker. A preservação da ordem importa igualmente. Um modelo que responde corretamente mas ignora a ordem temporal falhará em muitas verificações operacionais.

Outros benchmarks complementam o SOK-Bench. Conjuntos de dados de legendagem densa oferecem anotações longas ao longo de muitos eventos. Conjuntos maiores com mais de 10.000 clipes anotados suportam treinamentos mais ricos e podem melhorar a qualidade das descrições para legendagem densa e avaliação downstream levantamento sobre legendagem densa de vídeo. Ao selecionar um benchmark, as equipes devem casar a tarefa-alvo e o cenário de implantação. Para salas de controle operacionais, conjuntos que reflitam ângulos de câmera, oclusões e objetos específicos do domínio funcionam melhor. A visionplatform.ai aborda isso ao permitir que equipes melhorem detectores pré-treinados com dados específicos do local e então mapeiem eventos em resumos explicáveis para fluxos de trabalho dos operadores.

Unidades de raciocínio temporal: cadeia de pensamento em tempo real

O StreamingThinker introduz uma unidade de raciocínio em streaming projetada para suportar geração de cadeia de pensamento enquanto lê dados que chegam. A ideia central permite que um componente de modelo de linguagem grande produza raciocínios intermediários conforme novos quadros ou eventos chegam. Isso contrasta com pipelines em lote que aguardam clipes completos antes de gerar qualquer inferência. O mecanismo de streaming mantém uma memória de trabalho gerenciável e impõe atualizações que preservam a ordem na cadeia de pensamento interna. Como resultado, os sistemas podem responder a consultas multi-turno mais rapidamente e com vínculos temporais coerentes.

A unidade de raciocínio em streaming aplica controle de qualidade a cada passo intermediário. Ela filtra entradas ruidosas, verifica consistência com atualizações anteriores e descarta inferências de baixa confiança. Esses mecanismos reduzem o drift e ajudam o sistema a manter uma narrativa fundamentada. Em testes, o StreamingThinker reduziu a latência ponta a ponta em cerca de 30% em comparação com modelos em lote, o que o torna atraente para operações em tempo real StreamingThinker. A abordagem também ajuda quando os modelos precisam incorporar conhecimento externo ou alinhar-se a um conjunto de dados fundamentado, pois a natureza incremental facilita a integração com APIs externas e grafos de conhecimento.

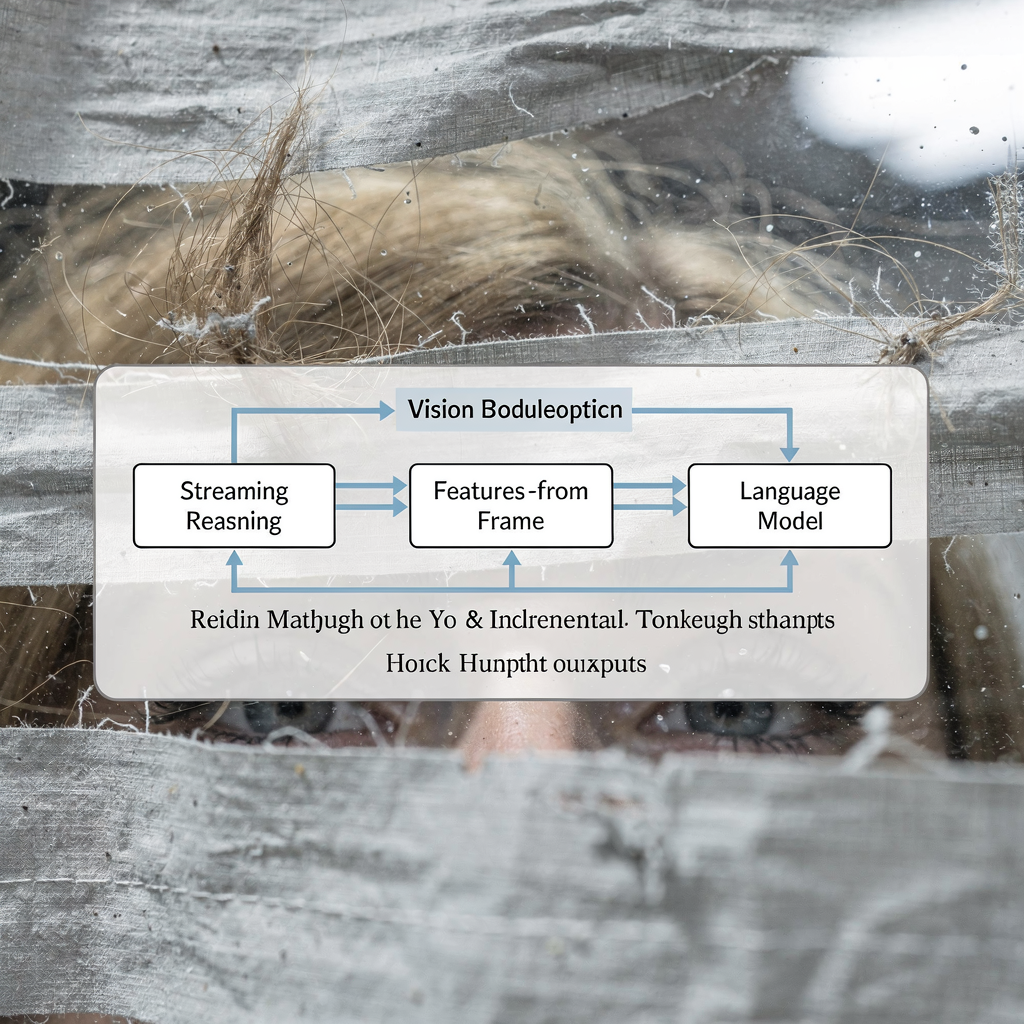

Sistemas práticos combinam unidades de raciocínio em streaming com especialistas. Por exemplo, um módulo de visão executa detecção por quadro. Em seguida, um pequeno agregador neural constrói trajetórias de curto prazo. Depois, um LLM consome esse resumo estruturado e gera explicações. Esse pipeline suporta um híbrido de percepção neural e composição simbólica. A visionplatform.ai segue um padrão similar: detectores streamam eventos para um Vision Language Model, que por sua vez alimenta o VP Agent Reasoning. O agente verifica alarmes, checa logs e recomenda ações, transformando detecções brutas em resultados operacionais. Esse projeto híbrido ajuda salas de controle a se adaptarem a cenários diversos e a manter traços de decisão auditáveis.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Insights e atualizações sobre StreamingThinker e SOK-Bench

Insights importantes emergiram de trabalhos recentes e avaliações experimentais. Primeiro, inferência em tempo real importa. Sistemas que raciocinam enquanto leem podem reduzir latência e melhorar a capacidade de resposta em cenários operacionais. Segundo, a integridade temporal continua essencial. Modelos devem preservar a ordem e evitar alucinações ao montar cadeias causais. Terceiro, a fusão multimodal aumenta a robustez. Quando áudio, metadados e logs de acesso complementam sinais visuais, os modelos conseguem verificar eventos com mais confiabilidade. O SOK-Bench e o StreamingThinker exemplificam esses pontos ao focarem em conhecimento alinhado e raciocínio incremental, respectivamente SOK-Bench, StreamingThinker.

Atualizações recentes no campo incluem sequências estendidas e esquemas de anotação mais ricos. Benchmarks agora pedem que os modelos lidem com clipes mais longos, fundamentem respostas em fatos externos e produzam rótulos temporais detalhados. Levantamentos sobre legendagem densa notam conjuntos maiores e tipos de eventos mais variados, o que ajuda modelos a generalizarem entre cenários levantamento sobre legendagem densa de vídeo. Além disso, sistemas experimentais testam video-LLMs que combinam pequenos codificadores de visão com raciocínio LLM leve para inferência on-prem. Esses mLLMs visam equilibrar capacidade com privacidade e restrições de computação.

Especialistas enfatizam explicabilidade e prontidão para implantação. Como observa a Dra. Jane Smith, “A capacidade de raciocinar sobre streams de vídeo em tempo real abre possibilidades transformadoras para sistemas de IA, permitindo que eles entendam cenários complexos à medida que acontecem, em vez de retrospectivamente” Dra. Jane Smith. De forma semelhante, os desenvolvedores de abordagens em streaming destacam que “Unidades de raciocínio em streaming com controle de qualidade não apenas melhoram a acurácia da geração de cadeia de pensamento, mas também garantem que o processo de raciocínio respeite a ordem temporal dos eventos” autores do StreamingThinker. Para os operadores, esses avanços significam menos falsos alarmes e recomendações mais rápidas e consistentes. A visionplatform.ai conecta estreitamente detectores, um Vision Language Model e agentes para entregar esses benefícios práticos on-prem.

Limitações no raciocínio em vídeo e direções futuras

O campo ainda enfrenta limitações significativas. Primeiro, streams ruidosos ou incompletos continuam sendo um grande problema. Quadros faltantes, oclusões e condições de pouca luz podem comprometer detecções. Segundo, escalar para durações de vídeo mais longas sobrecarrega tanto a memória quanto os orçamentos computacionais. Modelos frequentemente perdem o contexto temporal quando sequências se estendem além de alguns minutos. Terceiro, a integração multimodal impõe desafios de alinhamento e latência. Sincronizar áudio, metadados, logs de sensores e quadros de vídeo requer um desenho cuidadoso de buffers e timestamps.

Para enfrentar essas limitações, pesquisadores propõem frameworks híbridos e estratégias de compressão. Por exemplo, compressão temporal pode reduzir quadros redundantes preservando eventos-chave. Representações baseadas em grafos podem resumir interações de entidades e permitir consultas espaço-temporais eficientes. Outros times focam em melhorar IA explicável para que modelos possam justificar seus passos intermediários aos operadores. APIs padronizadas para streams de eventos e módulos de raciocínio também ajudariam profissionais a integrar componentes entre fornecedores.

Trabalhos futuros precisam viabilizar transferência entre domínios e adaptação à realidade específica do local. Implantações operacionais exigem modelos on-prem que respeitem governança de dados e o AI Act da UE. A visionplatform.ai adota uma abordagem on-prem para dar aos clientes controle sobre vídeo, modelos e implantação. Essa configuração suporta atualizações finas de modelos, classes personalizadas e trilhas de auditoria. Pesquisadores também devem refinar benchmarks para incluir cenários de vídeo longos, modalidades mais diversas e métricas que avaliem fidelidade temporal e explicabilidade. Finalmente, a comunidade deve trabalhar na padronização de protocolos de avaliação para que laboratórios possam comparar abordagens de forma justa e identificar quais frameworks superam baselines em condições realistas.

Perguntas Frequentes

O que é navegação temporal na compreensão de vídeo?

Navegação temporal refere-se a rastrear eventos e suas relações ao longo do tempo em um vídeo. Foca em ordenação, vínculos causais e em como sequências de ações produzem resultados.

Como o SOK-Bench ajuda a avaliar modelos?

O SOK-Bench fornece clipes anotados que alinham evidências visuais com conhecimento de mundo aberto. Pesquisadores o usam para testar se modelos conseguem fundamentar respostas em eventos observados e fatos externos SOK-Bench.

Que ganhos os benchmarks têm mostrado recentemente?

Sistemas de estado da arte relataram melhorias de precisão de cerca de 15–20% no SOK-Bench sobre baselines anteriores, refletindo melhor raciocínio temporal e contextual resultados do SOK-Bench.

O que é o StreamingThinker e por que importa?

O StreamingThinker é uma abordagem de raciocínio em streaming que permite que modelos produzam cadeia de pensamento incremental conforme os quadros chegam. Isso reduz latência e ajuda a manter a ordem no processo de raciocínio StreamingThinker.

Essas técnicas podem funcionar em salas de controle?

Sim. Sistemas que convertem vídeo em descrições legíveis por humanos e então permitem que agentes raciocinem sobre esses resumos suportam verificação e tomada de decisão mais rápidas. A visionplatform.ai combina detectores, um Vision Language Model e agentes para fornecer esse fluxo de trabalho.

Como sinais multimodais melhoram o raciocínio?

Adicionar áudio, logs e metadados ajuda a desambiguar eventos e verificar detecções. A fusão multimodal reduz falsos positivos e oferece contexto mais rico para relatórios de incidentes.

Quais são os principais desafios de implantação?

Desafios chave incluem lidar com streams ruidosos, escalar para vídeos longos e manter privacidade e conformidade. Implantações on-prem e pipelines auditáveis ajudam a enfrentar essas preocupações.

Onde posso aprender mais sobre conjuntos de dados de legendagem densa?

Levantamentos sobre legendagem densa de vídeo resumem técnicas e crescimento de conjuntos de dados, mostrando como coleções anotadas maiores suportam treinamentos e avaliações mais ricos levantamento sobre legendagem densa de vídeo.

Como avalio latência e preservação de ordem?

Meça o tempo de resposta ponta a ponta para consultas ao vivo e verifique se as saídas do modelo respeitam a ordem cronológica dos eventos. Abordagens em streaming frequentemente fornecem menor latência e melhor preservação da ordem.

Quais ferramentas práticas existem para busca forense em aeroportos?

Ferramentas de busca forense permitem que operadores consultem vídeo gravado usando linguagem natural e resumos de eventos. Para casos de uso em aeroportos, veja os recursos de busca forense da visionplatform.ai para consultas direcionadas em linhas do tempo busca forense.